-

BHT/Marti Gasch

01.02.2022„Roboter können uns ganz viel abnehmen“

Ob beim Putzen, in der industriellen Fertigung, im Service oder in der Pflege – Roboter werden zum Teil unseres Alltags. Dr.-Ing. Ivo Boblan, Professor im Studiengang Humanoide Robotik der Berliner Hochschule für Technik, erforscht mit seinem Team am Human.VR.Lab der BHT, wie Mensch und Technik künftig besser miteinander interagieren. Ein Fokus seiner Arbeit: Sich dafür einzusetzen, dass die Menschen ihre technischen Helfer akzeptieren. Welches sind die Voraussetzungen dafür, dass wir mit Robotern kommunizieren? Und wo liegen die Grenzen unserer Akzeptanz? Mehr darüber erzählt der Brain City-Botschafter und Sprecher des Forschungsverbunds „Humanoide Robotik und Mensch-Technik-Interaktion (HARMONIK)“ im Brain City-Interview.

Herr Prof. Dr.-Ing. Boblan. Sie sind einer der bekanntesten Roboterforscher in Deutschland. Was fasziniert Sie an dem Thema?

Ich bin mit Automaten aufgewachsen. Mit Technik, die sich bewegt. Bereits während meiner Schulzeit habe ich gelötet und mechanische Dinge zusammengeschraubt. Ich war fest entschlossen, Robotik zu studieren. Damals hieß das noch Automatisierungstechnik. Die Roboter, mit denen ich es während meines Studiums an der TU Dresden, und später dann an der TU Berlin zu tun hatte, waren noch sehr rudimentär in ihren Funktionen und sehr umständlich zu programmieren. Aber mir war damals – Anfang der 1990er Jahre – schon klar: Das ist die Zukunft.“

Was macht Roboter denn als Forschungsgebiet so spannend?

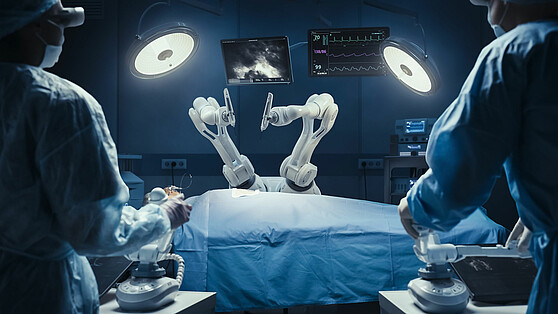

Roboter können uns ganz viel abnehmen. Sie sind ununterbrochen für uns im Einsatz. Und sie arbeiten viel präziser als wir. Die Technik ist heute natürlich viel ausgereifter als in den 1990ern. Wir beschäftigen uns nicht mehr nur mit Knickarm- oder SCARA-Robotern. Das sind die typischen in der Industrie verwendeten Gelenkarmroboter. Die Forschung geht inzwischen in Richtung menschenähnliche Roboter. Sie haben Ellenbogen-, Schulter-, Knie- und andere Gelenke – und damit auch mehr Freiheitsgrade in der Bewegung. Das Spannende daran ist: Man kann sie über frei verfügbare Software (Open-Source) wie zum Beispiel auf „GitHub“ und in Hochsprachen wie „Python“ programmieren und sie nach den eigenen Wünschen und Vorstellungen steuern und bewegen. Das ist auch für Studierende sehr einfach und schnell zu erlernen. Bei uns am Studiengang Humanoide Robotik arbeiten Studierende bereits ab dem zweiten Semester zusammen mit Doktorandinnen und Doktoranden an einem robotischen Thema.

Roboter nehmen zunehmend Einzug in unseren Alltag: Wo liegen die Herausforderungen in der Entwicklung?

Monotone Tätigkeiten stundenlang auszuführen, ist für uns Menschen weder angenehm noch gesund. Roboter hingegen können das sehr gut. Industrie-Roboter schweißen oder lackieren beispielsweise in der Automobilindustrie seit Jahren sehr zuverlässig und genau. Die Herausforderung liegt jetzt darin, Robotersysteme so weiterzuentwickeln, dass sie den Menschen auch im Alltag, also im Haushalt oder in der Pflege, entlasten. Indem sie etwa Physiotherapeutinnen und Physiotherapeuten durch das Heben und Tragen von Pflegebedürftigen unterstützen. Oder indem sie älteren Menschen schwer zu erreichende Gegenstände wie Tassen aus dem Regal holen. Es geht hier um körperlich belastende Routine-Tätigkeiten. Ganz wichtig ist: Das Reden, Zuhören und andere soziale Interaktionen sollen weiterhin Menschen übernehmen. Grundsätzlich stellt sich allerdings die Frage: Was wollen Menschen in Zukunft noch tun – und welche Tätigkeiten können besser Roboter übernehmen.

In Ihrer Forschung beschäftigen Sie sich auch mit dem Thema „Soft Robotik“: Inwiefern müssen sich die Roboter in ihrem Verhalten dem Menschen anpassen?

Damit Roboter künftig in unseren Alltag Einzug nehmen können, müssen sie in ihren Bewegungen weich und nachgiebig sein. Sie müssen sich unseren Eigenschaften anpassen. Nur dann akzeptieren wir sie; nur dann fühlen wir uns wohl mit ihnen. Die heutigen Industrieroboter bewegen sich noch sehr steif. Das ist uns Menschen fremd, denn in der Natur gibt es nur resiliente Bewegungen. Das heißt konkret: Wir müssen die Roboter der Zukunft in den Antrieben und Gliedmaßen weicher machen. Seit längerer Zeit gibt es auf dem Markt nachgiebige Druckluftantriebe, wie zum Beispiel fluidische Muskeln. Diese sind inhärent nachgiebig und können, wenn man Sie paarig verschaltet, als menschenähnliche Gelenke in Robotersystemen weiche Bewegungen erzeugen. In naher Zukunft werden Roboter so günstig sein, dass fast jeder sie sich leisten kann. Die Frage ist: Werden wir sie auch akzeptieren? Das wird nur geschehen, wenn wir sie so menschenähnlich wie möglich machen. Und damit meine ich nicht, dass sie „humanoid“ aussehen – also Haut, Haare und ein Gesicht haben, sondern dass sie sich „humanoid“ verhalten.

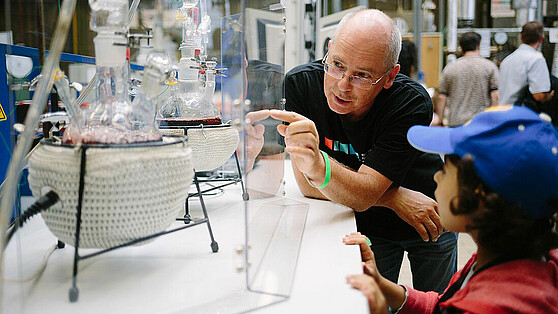

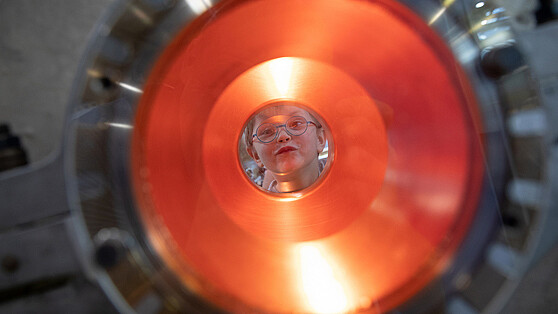

Prof. Dr.-Ing. Ivo Boblan mit seinem Team und Roboter "Digit"

Wie sollten Roboter denn aussehen? Der in Berlin sehr beliebte Roboter „Myon“ aus dem Forschungslabor Neurorobotik Ihres Kollegen Prof. Dr. Manfred Hild hat eine humanoide Gestalt. Steht das nicht im Widerspruch zu dem, was Sie eben gesagt haben?

Ganz und gar nicht. Myon hat zwei Arme, zwei Beine und etwas, das man Kopf nennen kann. Aber er ist klein, kann wenig tragen, hat Elektromotoren in den Gelenken und seine Finger bewegen sich nicht. Er hat auch keine Haut, keine Haare und kein menschliches Gesicht. Er ist auf den ersten Blick als Technik zu erkennen. Wenn ich von humanoiden Robotern spreche, meine ich solche, die man aus der Entfernung für Menschen halten könnte. Wie der vor Kurzem auf der CES 2022 in Las Vegas vorgestellte AMECA AI ROBOT oder „Geminoid HI-1“, der robotische Zwilling von Hiroshi Ishiguro. Wenn Roboter uns zu sehr ähneln, werden sie uns unheimlich. Nach der „Ucanny Valley“ („Unheimliches Tal“)-Hypothese, die der japanische Robotiker Masahiro Mori bereits 1970 aufgestellt hat, sinkt die Akzeptanz beim Menschen mit zunehmender Menschenähnlichkeit des Roboters drastisch und mündet schließlich in einem Grusel-Effekt. Um von uns gruselfrei akzeptiert zu werden, muss ein Roboter nicht einmal einen Kopf haben. Ein Display zur Ansprache könnte ausreichen. Alle diese Fragen sind aber noch so gut wie ungeklärt und können beziehungsweise müssen sogar von den Menschen, die mit Ihnen umgehen wollen, beantwortet werden.

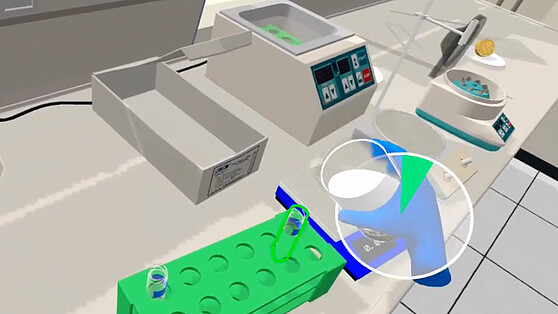

Im Human.VR.Lab der BHT testen Sie Roboter mittels VR/AR und KI in unterschiedlichen Anwendungsbereichen. Welche sind das?

Unser Human.VR.ab ist ein sehr gut ausgestattetes Labor, in dem wir beispielsweise Bewegungsanalysen durchführen können. Das heißt, wir kleben Marker auf die Gelenke von Menschen, um ihre Gelenkbewegungen nachzuverfolgen. Diese Bewegungsmuster übertragen wir dann auf Roboter. So versuchen wir etwa, unseren Roboter Digit „menschlicher“ laufen zu lassen. Per virtueller und erweiterter Realität (VR/AR) können wir ihm außerdem weitere menschliche Merkmale überblenden. Auf diese Weise können wir den Grad der Akzeptanz testen, ohne den gesamten Roboter tatsächlich bauen zu müssen. Das ist deutlich schneller und billiger. Wir werden am Human.VR.Lab auch mit Techniksoziologen zusammenarbeiten, um besser zu verstehen, was die Freude im Umgang mit Robotern erhöhen kann.

Können Sie ein Beispiel nennen?

Wenn ein Roboter uns die Hand um 30 Grad verwinkelt entgegenstreckt, entscheiden wir Menschen spontan, ob wie diese Aktion „reparieren“ oder nicht. Wir nehmen dann entweder die Hand und akzeptieren die Abweichung in der Bewegung – oder auch nicht. Die Frage lautet hier: Bis zu welcher Position beziehungsweise bis zu welcher Abweichung von der Erwartungshaltung fühlt sich der Mensch noch angesprochen und ab wann ignoriert er die ausgestreckte Roboterhand? Und wie müssen wir die Technik verändern, damit Menschen im Umgang mit Robotern möglichst viele Fehler der „noch unzureichenden“ Roboter verzeihen und die Interaktion reparieren? Mit diesem Thema haben wir uns beispielsweise im Rahmen meiner vom BMBF geförderten Nachwuchsforschergruppe MTI-engAge an der TU Berlin beschäftigt.

Im Projekt „EPI“ hingegen befassen Sie sich mit Exoskeletten – also mit äußeren Stützstrukturen für den Menschen, richtig?

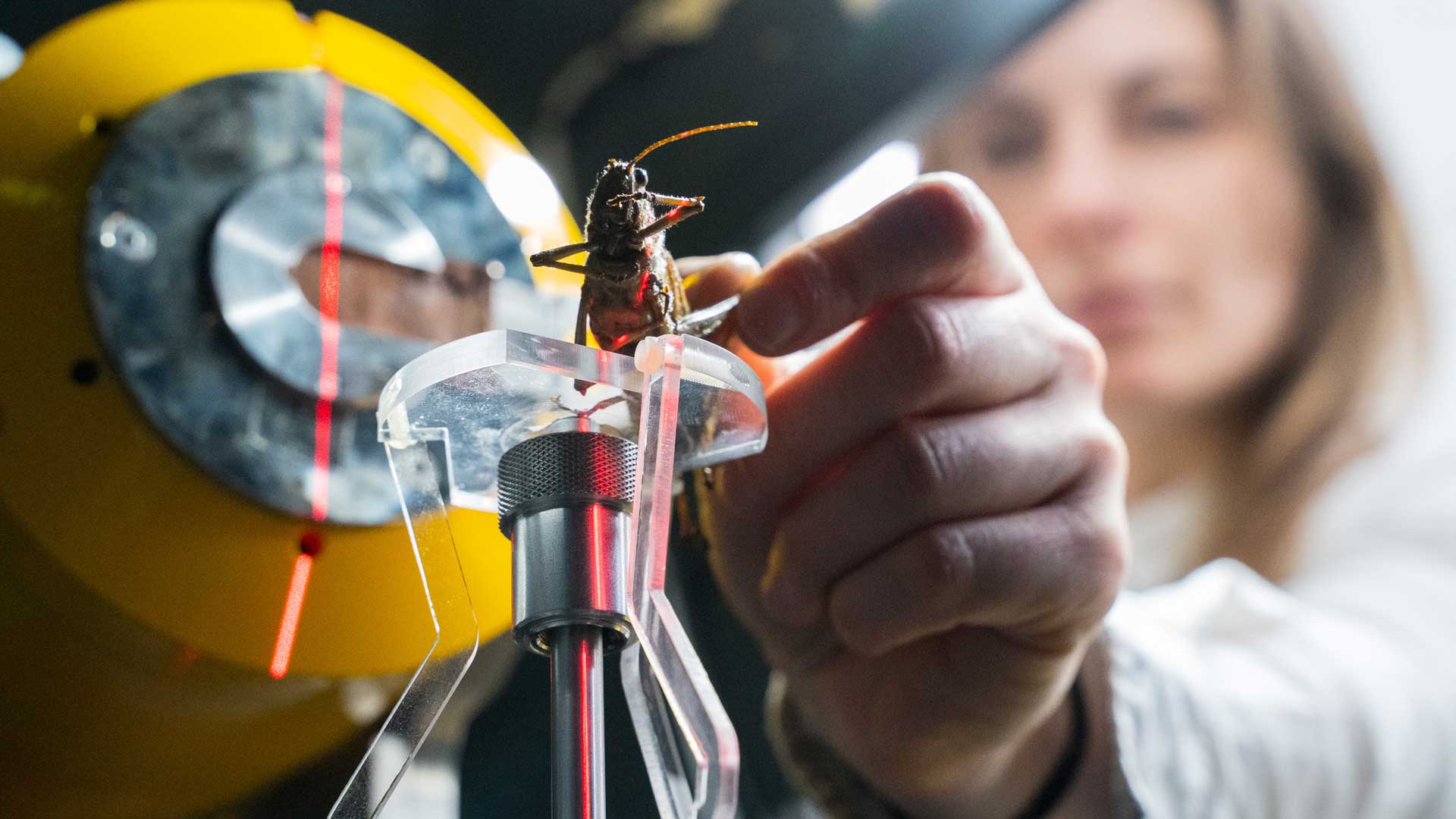

Ja genau. In dem vom IFAF Berlin geförderten Projekt, das aktuell noch in der Verlängerung läuft, haben wir zusammen mit der Hochschule für Technik und Wirtschaft Berlin (HTW Berlin) und mehreren Industriepartnern zwei passive Exoskelette nach dem Vorbild des Heuschreckensprungs entwickelt. Diese sollen den Menschen mechanisch dabei unterstützen, schwere Gegenstände zu heben und zu transportieren. Es geht uns dabei nicht darum, den Menschen mit Superman-Fähigkeiten auszustatten. Vielmehr könnten Rückenleiden, Bandscheibenvorfällen, Knieprobleme und auch Ermüdungserscheinungen beim Arbeiten unter hoher körperlicher Belastung reduziert oder Menschen mit Bewegungseinschränkungen mechanisch unterstützt werden. Die im Rahmen des Projekts entwickelten Exoskelette werden aktuell an realen Arbeitsplätzen bei unseren Projektpartnern getestet.

Was ist die Zielsetzung des Forschungsverbunds „Humanoide Robotik und Mensch-Technik-Interaktion (HARMONIK)“ der BHT, dessen Sprecher Sie ja sind?

An der BHT haben wir Ende 2020 zwei Forschungsverbünde ins Leben gerufen: „Data Science +X“ beschäftigt sich unter anderem mit Lernverfahren, Data Mining und Data Quality. Mit HARMONIK möchten wir beispielsweise anhand existierender Robotersysteme die Mensch-Roboter-Interaktion optimieren. Das passiert auf verschiedenen Ebenen. Einerseits untersuchen wir aktuell in einer Bachelorarbeit, wie man intuitiv mit einem Roboter kommunizieren will, etwa um ihm mitzuteilen, dass er doch bitte eine Kiste aufheben soll: Spricht man ihn an, steuert ihn mit einem Joystick oder schaut ihn an und zeigt dabei gleichzeitig auf die Kiste? Andererseits wollen wir, um das Erlebnis Interaktion zu verbessern, die Robotersysteme verändern, ohne sie immer wieder neu kosten- und zeitintensiv entwickeln zu müssen. Das machen wir mittels VR/AR, indem wir – wie bereits erwähnt – die Unzulänglichkeiten der Roboter mit virtuellen Erweiterungen, wie zum Beispiel einem Kopf oder filigranen Händen, überblenden und diese vermischte reale und virtuelle Welt in der Mensch-Roboter-Interaktion testen. Das alles mache ich natürlich nicht allein, sondern in enger Kooperation mit meinen Kollegen Prof. Dr. Kristian Hildebrand, Prof. Dr.-Ing. Joachim Villwock und Prof. Dr.-Ing Hannes Höppner. 15 Professorinnen und Professoren aus den Gesellschaftswissenschaften, den Lebenswissenschaften, der Informatik, der Robotik und dem Maschinenbau arbeiten im Rahmen des Verbunds interdisziplinär zusammen. Data Science +X und HARMONIK forschen und lehren im Human VR_Lab eng verzahnt, um Technik näher an den Menschen zu bringen. Ein weiteres Ziel von HARMONIK ist es, das Human VR-Lab zu verstetigen. Um einen Ort zu schaffen, an dem sämtliche Player hochschulübergreifend an menschzentrierter Technik forschen und lehren können. Ein großer Vorteil von Berlin ist ja: Hier kann man Dinge schnell umsetzen, weil wir nicht entlang alter Leitplanken denken. Und weil es hier viele Menschen gibt, die neue Ideen und Tools aufgreifen und weiterentwickeln.

Der Titel des Lunchtalk #08 der BHT lautete. „Wie kommunizieren Mensch und Roboter in Zukunft?“ Haben Sie darauf eine Antwort?

Es wird immer einen Unterschied geben zwischen der Sensorik der Technik und der des Menschen. Wir haben halt unsere klassischen fünf Sinne; die Technik hat Kamera, Lautsprecher und Mikrofon. Idealerweise werden wir mit der Technik sprechen, weil das am einfachsten ist. Was uns aber emotional ausmacht, ist vor allem das Fühlen und Gefühlt-werden. In naher Zukunft wird es sicherlich auch Tools geben, mit denen wir fühlen und so Nähe über die Distanz bringen können – beispielsweise in Videokonferenzen. Wir werden vermutlich auch über die Distanz riechen können. Das sind emotionale Verbindungen, die wir Menschen brauchen. Wir Forscherinnen und Forscher arbeiten daran, dass Roboter künftig mit sämtlichen menschlichen Sinnen kommunizieren können. (vdo)