-

HIIG

26.01.2021„Ein nachhaltiges Ziel unserer Arbeit ist es, zu verdeutlichen, was die Technik eigentlich kann“

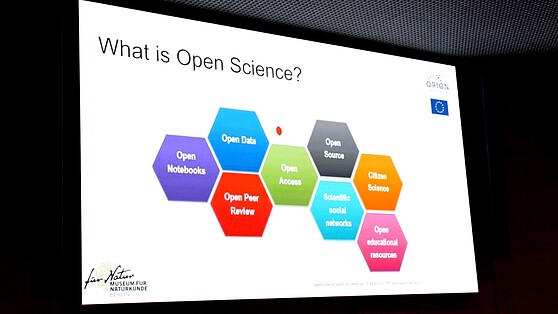

Wie gestalten wir die Algorithmen, die unsere Gesellschaft prägen? Und welche Regeln müssen bei der Programmierung von KI gelten, damit diese dem Wohl aller dienen? Im August startete das von der Stiftung Mercator geförderte internationale Forschungsprojekt „Ethik der Digitalisierung“. Der erste „Research Sprint“ des auf rund zwei Jahre angelegten Vorhabens endete im Oktober 2020. Dreizehn Fellows beschäftigten sich zehn Wochen lang mit den Herausforderungen, die mit dem Einsatz von KI in der Moderation von Online-Inhalten einhergehen. Koordiniert wurde das Teilprojekt vom Alexander von Humboldt Institut für Internet und Gesellschaft (HIIG). Mehr darüber erzählt Prof. Dr. Wolfgang Schulz, Forschungsdirektor im Bereich „Internet und Medienregulierung“ am HIIG, im Brain City-Interview.

Herr Prof. Dr. Schulz, der vom HIIG koordinierte erste „Research Sprint“ des internationalen Forschungsprojekts „Ethik der Digitalisierung – von Prinzipien zu Praktiken“ ist inzwischen abgeschlossen. Warum wurde das Projekt ins Leben gerufen?

Ausgangspunkt war, dass im Bereich Digitalisierung allgemein sehr abstrakte ethische Regeln entwickelt werden. Zwar wird das Thema bereits seit längerer Zeit diskutiert, die Ergebnisse sind allerdings noch nicht konkret genug, als dass Anwender*innen und Entwickler*innen tatsächlich damit arbeiten könnten. Unsere Zielsetzung ist es, in multidisziplinärer Zusammenarbeit praktikable Lösungen für unterschiedliche Stakeholder zu entwickeln.

An welche Stakeholder denken Sie dabei?

Es sollen Politiker*innen und Regulierer*innen etwas daraus lernen können, aber auch Unternehmen, die Produkte entwickeln oder Anwendungskontexte zur Verfügung stellen. Es können sich aber auch Ratschläge für die Nutzer*innen aus unserer Arbeit ergeben. Wie überlegen kontinuierlich: Wer kann von unseren Ergebnissen profitieren?

„AI and Content Moderation“ lautet das Thema des ersten „Research Sprints“ des Projekts. Welches sind die Kernergebnisse?

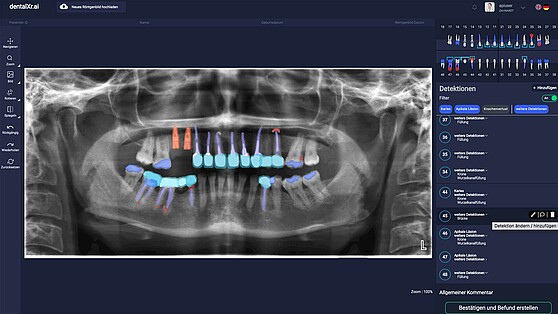

Lassen Sie mich dafür etwas ausholen: Am Anfang des Projekts stand die Beobachtung im Raum, dass insbesondere in COVID-Zeiten die großen Social-Media-Plattformen, wie Facebook, Twitter oder YouTube, stärker als zuvor auf technische Mechanismen zugreifen, um Inhalte zu identifizieren die entweder rechtswidrig sind oder gegen ihre eigenen Standards verstoßen. Sie lassen diese zum Teil auch durch die Technik selbstständig löschen. Dabei können viele Probleme auftreten. Ein Beispiel ist Intransparenz. Man weiß nicht, nach welchen Kriterien die Software eigentlich löscht. Unternehmen könnten auch versuchen, über die Algorithmen die Meinungsbildung zu manipulieren. Möglich ist es außerdem, dass Inhalte gelöscht werden, die rechtmäßig sind und nicht gegen die Standards der Plattform verstoßen, weil der Algorithmus das nicht erkennt. Die Kolleg*innen haben als Ergebnis des ersten Research Sprints drei Policy Briefs entwickelt, die im Wesentlichen bei zwei Punkten ansetzen.

Und welche Punkte sind das?

Einer davon ist das Audit: die Prüfung der Algorithmen durch Dritte, also nicht die Unternehmen selbst. Dazu machen die Forscher*innen sehr konkrete Vorschläge. Sie fordern, dass die Unternehmen selbst Geld in einen Pool packen sollten, um ein unabhängiges menschliches Audit zu finanzieren. Außerdem fordern sie Transparenz, die weit über das hinausgeht, was die Unternehmen heute leisten. Also Transparenz im Sinne einer Selbsterklärung der Unternehmen – neben dem Audit durch Dritte. Über solche standardisierten Erklärungen ließe sich beispielsweise vergleichen, ob Facebook anders agiert als YouTube oder Twitter. Sehr wichtig finde ich auch, dass sich die Kolleg*innen gefragt haben, wem die Transparenz eigentlich dienen soll.

Können Sie das konkretisieren?

Der Begriff der Transparenz wird oft sehr allgemein betrachtet. Dabei ist es extrem wichtig zu fragen: Wer sollte warum etwas wissen? Es gibt erhebliche Unterschiede bezüglich dessen, was Nutzer*innen, Regulierer*innen oder etwa Wettbewerber*innen wissen müssen. Der Policy Brief, den die Kolleg*innen hierzu erarbeitet haben, trägt dazu bei, die Debatte differenzierter zu führen.

Eine dritte Empfehlung der Projektteilnehmer*innen bezieht sich auf die Redefreiheit im digitalen Raum.

Die Forschungsgruppe hat festgestellt, dass immer noch deutliche Grenzen existieren in Bezug auf das, was Algorithmen erkennen können und was nicht. Daraus folgt die sehr einfache, aber wichtige Empfehlung, dass menschliche Reviews grundsätzlich den technischen vorzuziehen sind. Um das an einem Beispiel zu erläutern: Wenn ein Algorithmus nach einer bestimmten Formulierung sucht, wird er vielleicht auch etwas löschen, das sich kritisch oder satirisch mit einem radikalen Inhalt auseinandersetzt. So etwas zu verstehen, ist hochkomplex, selbst für hocheffiziente Systeme der Spracherkennung. Ein nachhaltiges Ziel unserer Arbeit ist es daher, zu erkennen und zu verdeutlichen, was die Technik eigentlich kann und wo es noch Grenzen gibt. Damit beispielweise Politiker*innen und Regulierer*innen ihre Forderungen laufend darauf einstellen können. Man braucht einen dauerhaften Dialog, damit man den technischen Fortschritt nicht über- oder unterschätzt und eine halbwegs klare Vorstellung davon hat, was die Systeme können und was nicht.

Die im Projekt angewandten „Sprints“ sind ein sehr innovatives Forschungsformat. Was kann man sich darunter vorstellen?

Wir glauben, dass interdisziplinäre Arbeit eigene Formate braucht, einen gewissen Zeitrahmen und eine Struktur. Nur so kann sie funktionieren. Für die Gesellschaft ist es sehr wichtig, dass Wissenschaft solche Strukturen entwickelt. In unserem Bereich der Forschung ist das Format der „Sprints“ oder „Clinics“ relativ unerprobt. Wir experimentieren noch damit. Der Begriff der Sprints ist aus der Softwareentwicklung übernommen, Clinic ist natürlich eine Metapher aus dem medizinischen Bereich. Clinics sind für uns die kleineren Forschungsformate, Sprints laufen über einen längeren Zeitraum. Gemeinsam ist beiden, dass für die Lösung eines spezifischen Problems eine interdisziplinäre Gruppe zusammenkommt, die im Rahmen eines geordneten Verfahrens bestimmte Problemlösungen erarbeitet. Wie dieses Verfahren jeweils geordnet ist, dazu machen wir immer neue Erfahrungen. Dazu gehört zum Beispiel auch die Frage, wie viel Spielraum man einer Gruppe bei der Konkretisierung des Problems gibt.

Arbeiten Sie auch mit der Industrie zusammen?

Viele der Plattformen, die wir uns anschauen, werden von großen Unternehmen entwickelt und betrieben. Wenn man Unternehmen zu früh in den Prozess reinbringt, prägen sie möglicherweise die Arbeit der Gruppe zu stark. Andererseits sollen Forschungsergebnisse nicht im luftleeren Raum entstehen, sondern anschlussfähig sein. Wir suchen daher den Kontakt zu Industrievertretern. Sie werden allerdings zu einem Zeitpunkt in das Projekt einbezogen, am dem das Thema bereits konkretisiert ist und bringen ihre Praxisansätze mit ein. Sie erhalten auch Zugang zu den Ergebnissen. Möglich ist es auch, dass wir Unternehmen noch einmal einladen, um die Forschungsergebnisse mit ihnen zu diskutieren. In Bezug auf die Strukturierung des Arbeitsprozesses, der sich bei einem Sprint über zwei bis drei Monate erstrecken kann, lernen wir ständig dazu.

Das Projekt „Ethik der Digitalisierung“ ist schon von der Sache her international angelegt. Wie wird diese Internationalisierung projektintern umgesetzt?

Das Projekt ist sehr international, wir verstehen uns als Ermöglicher. Internationalität kommt auf unterschiedliche Art und Weise in das Projekt: Zum einen werden die einzelnen Sprints oder Clinics über das organisierende Network of Internet & Society Research Center (NoC) in Kooperation mit Partner-Instituten in anderen Ländern durchgeführt. Zum anderen schreiben wir beim Rekrutieren der beteiligten jungen Wissenschaftler*innen international über unsere Partnerorganisationen aus, um möglichst gemischte Teams zu erhalten.

„Gemischt“ heißt in diesem Fall vor allem interdisziplinär?

Ganz klar. In unseren Teams arbeiten Informatiker*innen, Jurist*innen, Forscher*innen aus dem Governance-Bereich, die nicht juristisch tätig sind, Politik- oder Kommunikationswissenschaftler*innen und Ethiker*innen. Die weitere Zusammensetzung der Teams bestimmt sich in Abhängigkeit vom Anwendungskontext. Wir suchen typischerweise keine Studierenden, sondern fortgeschrittene Doktorand*innen oder Wissenschaftler*innen in der Postdoc-Phase, da wir eine gewisse Expertise voraussetzen.

Welchen Vorteil bietet der Wissenschaftsstandort Berlin dem HIIG und dem Projekt?

Nach Berlin kommen die Kolleg*innen sehr gern, wir können mit dem Standort daher international werben. Außerdem ist das wissenschaftliche Umfeld für uns als Institut extrem gut. Wir haben die Humboldt-Universität zu Berlin (HU Berlin) bereits als Mitgründerin unseres Instituts an Bord – ebenso wie das Wissenschaftszentrum Berlin für Sozialforschung (WZB) und die Universität der Künste Berlin (UdK Berlin). Unsere Vernetzung reicht aber noch viel weiter, sie umfasst zum Beispiel das Einstein Center Digital Future. Davon profitieren wir sehr stark. Bei unseren Sprints sind immer auch Berliner Wissenschaftler*innen dabei. (vdo)

Projekt „Ethik der Digitalisierung“

#ki_berlin

Policy Briefs des ersten Sprints „AI in Content Moderation“

- Bloch-Wehba, H., Fernandez, A., Morar, D. (2020). Making Audits Meaningful. HIIG Research Sprint “AI in Content Moderation”, Project: “Ethics of Digitalisation”.

- Iramina, A., Spencer-Smith, C., Yan, W. (2020). Disclosure Rules for Algorithmic Content Moderation. HIIG Research Sprint “AI in Content Moderation”, Project: “Ethics of Digitalisation”.

- Cowls, J., Darius, P., Golunova, V., Mendis, S., Prem, E., Santistevan, D., Wang, W. (2020). Freedom of Expression in the Digital Public Sphere. HIIG Research Sprint “AI in Content Moderation”, Project: “Ethics of Digitalisation”.