Von Fischen, Bienen und selbstfahrenden Autos

07.06.2019 | Die Brain City Berlin gilt als einer der führenden Standorte für Künstliche Intelligenz in Deutschland. Rund 30 Prozent der bundesdeutschen KI-Unternehmen sitzen in der Hauptstadt – und knapp die Hälfte der KI-Start-ups. Ein wesentlicher Treiber dieser Entwicklung: An zahlreichen Instituten, Universitäten und Hochschulen wird auf hohem Niveau an der Entwicklung innovativer Anwendungen und Lösungen geforscht. So etwa am Dahlem Center für Machine Learning and Robotics (DCMLR): Hier arbeitet man unter anderem daran, das autonome Fahren zu perfektionieren. Und nutzt Roboter und KI, um von Bienen und Fischen zu lernen.

Der kleine Guppy schaut aus wie seine Artgenossen: Er ist nur wenige Zentimeter lang, hat große Augen mit schwarzen Pupillen und seine Haut glänzt metallisch. Doch da hört die Ähnlichkeit mit den realen Fischen auch schon auf. Denn dieser Guppy ist kein Wesen aus Fleisch, Blut und Gräten, sondern ein Robofish: Gerade „schwimmt“ er auf einer feinen, durchsichtigen Stütze durch ein viereckiges, flaches Testbecken.

Gesteuert wird er dabei von einem Roboter unterhalb der Bodenplatte, der per Software gelenkt seine Bahnen zieht. Mal bewegt sich der Robofish so auf eine kleine Gruppe echter Guppys im Becken zu, mal folgen ihm diese nach. Zwei Kameras verfolgen das Geschehen und zeichnen sämtliche Bewegungen auf.

Social Bonding mit dem Robofish

Wie sich unschwer erraten lässt: Der Roboter bewegt sich nicht einfach nur so durch das Aquarium. Er ist vielmehr Protagonist eines Forschungsprojekts im Biorobotics Lab des Dahlem Center for Machine Learning and Robotics (DCMLR) an der Freien Universität Berlin (FU Berlin). „Am DCMLR nutzen wir Roboter und KI, um die biologische Intelligenz von Fischen und Bienen zu erforschen“, erläutert Dr. Tim Landgraf. Als Professor für Informatik leitet er das Projekt Robofish und zugleich die Arbeitsgruppe „Künstliche und Kollektive Intelligenz“. Zielsetzung des Projekts: Die Roboter sollen von den Fischen lernen. Das heißt, sie sollen ihr Verhalten intelligent dem Schwarm anpassen, so dass ihnen die Fische hinterherschwimmen. Dafür werden die Bewegungs-Daten von einer Software abgeglichen, analysiert und daraus Bewegungsmuster errechnet.

Erste Erfolge konnten Tim Landgraf und sein Team bereits verzeichnen: „Es hat sich etwa gezeigt, dass die Guppys einem Robofish ungefähr viermal länger folgen, wenn er die Reaktionen der anderen in seinem Verhalten berücksichtigt. Wenn Fische beispielsweise genervt ausweichen, und der Roboter dann weniger aggressiv anschwimmt, bauen die Fische Vertrauen zu ihm auf – eine soziale Bindung, die sich in längerem Führungsverhalten niederschlägt.“

Bienen navigieren stark über die Sicht

In ihrer Arbeit mit Bienen wiederum wollen Tim Landgraf und sein Team vor allem herausfinden, wie diese kommunizieren. Langfristig geht es auch hier darum, gewonnene Daten und Erkenntnisse in die Entwicklung neuer Technologien einfließen zu lassen. „Man weiß bisher noch nicht einmal genau, wie Bienen sich orientieren. Wie ihr Gehirn die Struktur der Welt abbildet“, so Tim Landgraf.

In dem Projekt NeuroCopter etwa konnten der Forscher und seine Kolleg*innen immerhin belegen, dass Bienen stark über die Sicht navigieren: Tiere, die per Quadrokopter an einer Futterstelle abgefangen und etwa 400 Meter weiter ausgesetzt wurden, fanden trotzdem auf kurzem Wege nach Hause. Dabei hingen sie an einem dünnen Draht, so dass sie freie Sicht auf die Welt unter ihnen hatten. Offenbar hatten die Bienen Bilder von Landmarkierungen im Gedächtnis abgespeichert. So konnten sie schneller nach Hause navigieren als eine Kontrollgruppe in einem blickdichten Kasten.

Später konnte Landgraf mit seinen Kolleg*innen auch Hirnströme per Elektroden messen. Die ersten deutlichen Signale von Nervenzellen von Bienen im Flug. Aktuell tracken die Forscher*innen am DCMLR die Bienen eines Stocks auf dem Instituts-Gelände, um über Bienen-Generationen hinweg mehr über deren Verhalten zu erfahren – und dieses Wissen in die Entwicklung intelligenter Technologien zu übersetzen.

Die heute eingesetzte KI ist noch schwach

Auch wenn die Forschung im Bereich der Künstlichen Intelligenz durch Projekte wie diese rege Fortschritte macht – autonom denkende und handelnde Systemen und Maschinen wird es noch lange nicht geben. Das bestätigt Professor Dr. Raúl Rojas.

Der Spezialist für künstliche Neuronale Netze rief 1989 als Habilitant die Arbeitsgruppe KI an der FU Berlin ins Leben und legte damit den Grundstein für das Dahlem Center for Machine Learning and Robotics „Die heute eingesetzte Künstliche Intelligenz ist eine rein datengetriebene, sogenannte schwache KI. Von der starken, selbstlernenden und -handelnden KI sind wir noch weit entfernt“, so der KI-Experte und ergänzt: „Künstliche Intelligenz kann derzeit nicht mehr sein als ein Assistenzsystem für den Menschen, denn datengetriebene Ansätze arbeiten anders als das menschliche Gehirn. Der Mensch leistet nach wie vor die Kopfarbeit.“

Autonome Fahrzeuge werden mit Sicherheit kommen

Alexa, Siri oder Saug-Roboter – schwache KI findet sich inzwischen in fast jedem Haushalt. Künstliche Intelligenz hilft Medizinern Röntgen- oder Blutbilder abzugleichen und in vielen Fabriken sind bereits Roboter im Einsatz. In die meisten Autos sind heute bereits intelligente Park- und Fahr-Assistenzsysteme integriert. Doch der Einsatz starker KI liegt auch hier noch in weiter Ferne. „Autonome Fahrzeuge werden mit Sicherheit kommen. Die Frage ist bloß, wann.

Ich persönlich schätze, es wird mindestens noch 20 Jahre dauern, bis wir selbstfahrende Autos in den Straßen sehen“, so Professor Dr. Daniel Göhring, der am DCMLR zusammen mit Raúl Rojas die Arbeitsgruppe Autonome Fahrzeuge leitet.

„MadeInGermany“ – das autonome Testfahrzeug

Daniel Göhring spricht aus Erfahrung. Denn bereits seit 2011 fahren sowohl ein Elektro-Auto als auch ein Passat, der in Kooperation mit der VW-Forschung zum autonomen Fahrzeug umgebaut wurde, auf fest definierten Teststrecken durch Berlin. Eines davon ist das Testfeld des Berliner Forschungs- und Entwicklungsprojekts Sicheres automatisiertes und vernetztes Fahren auf dem Digitalen Testfeld Stadtverkehr in Berlin Reinickendorf (SAFARI).

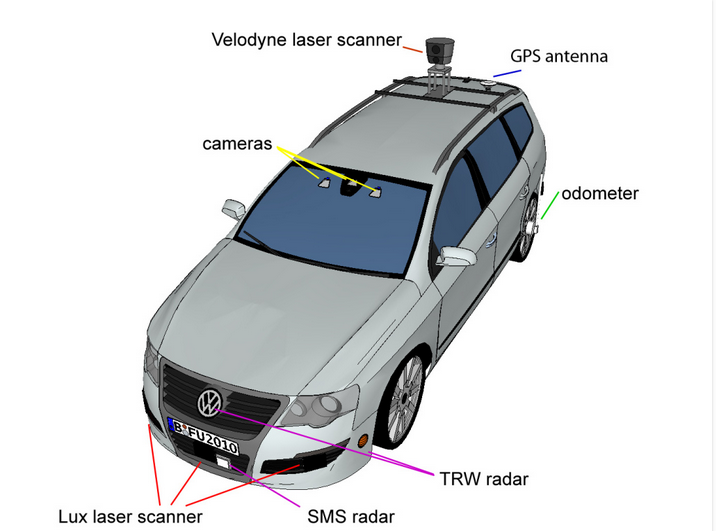

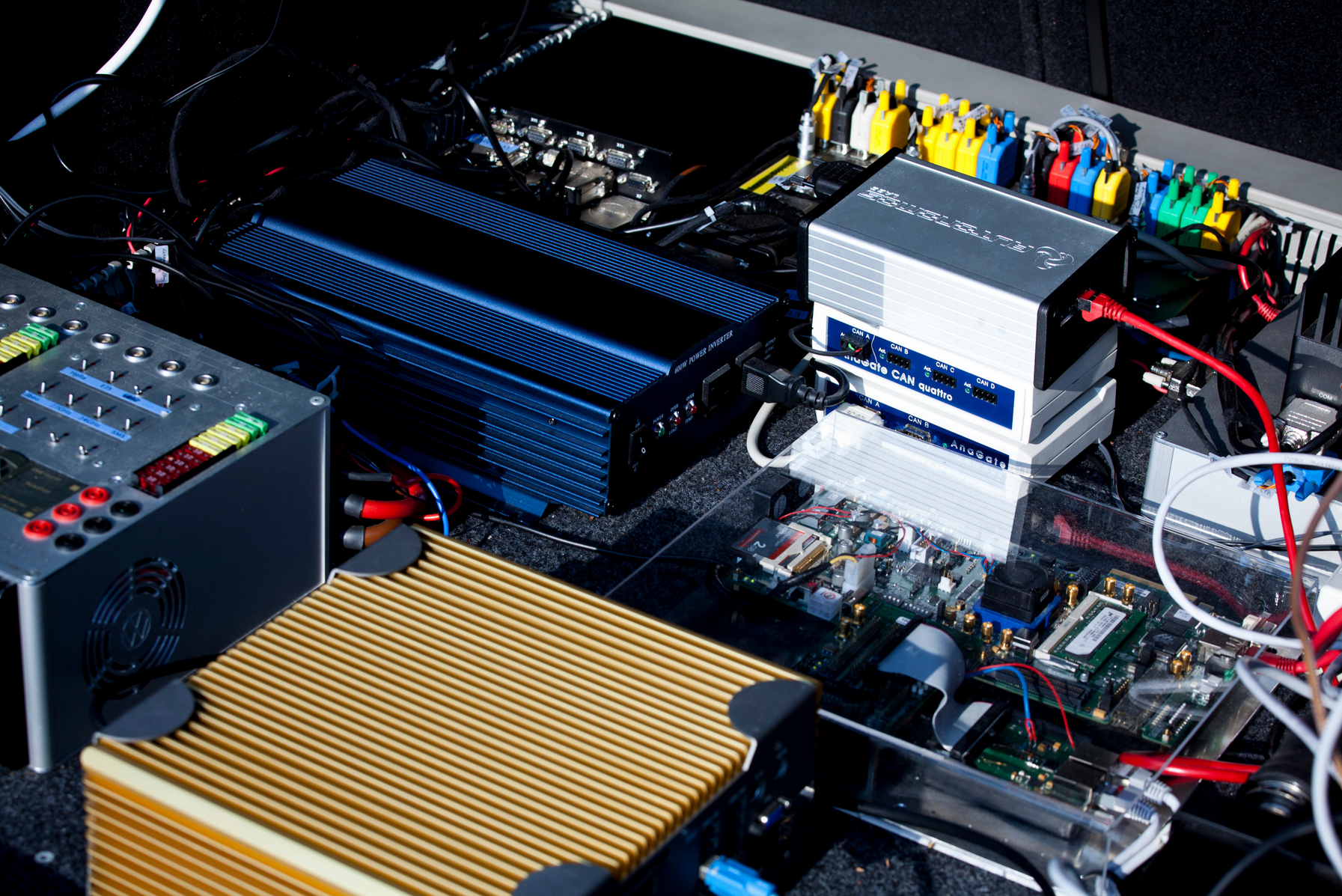

Der Passat mit dem Namen MadeInGermany ist mit Lasersensoren, Kameras, GPS, Beschleunigungssensoren und Radar ausgestattet. Durch sogenannte Sensor-Fusion, also den Abgleich der Daten aus unterschiedlichen Sensorquellen in Echtzeit, kann er computergesteuert autonom fahren und schnell und präzise auf Steuerbefehle des Rechners reagieren.

Bäume als zusätzliche Orientierungspunkte

Neben GPS-Daten orientiert sich das Fahrzeug vor allem an markanten Wegmarkierungen wie Bäumen. Auch mit den Ampeln im Testfeld Reinickendorf kann der Wagen bereits über eine Kommunikationsschnittstelle kommunizieren. Trotzdem sitzt aus Sicherheitsgründen ein Fahrer im Auto, der jederzeit das Steuer übernehmen kann. Zusätzlich hat ein Co-Pilot während der Fahrt die Berechnungen des Zentralrechners immer im Blick.

„Was unser Fahrzeug noch nicht perfekt kann, ist improvisieren – zum Beispiel an Baustellen oder Umleitungen trotz veränderter oder fehlender Markierungen den richtigen Weg zu finden“, so Raúl Rojas. Auch Gesten und Intentionen anderer Verkehrsteilnehmer kann MadeInGermany bisher nicht erkennen und interpretieren.

Tanken wie die Bienen

Vielleicht wird die KI-Forschung auch hier von den Bienen lernen können. Im Bereich Elektromobilität gibt es bereits erste Ansätze. Denn wie die Forscher in Berlin-Dahlem herausfanden, pumpen hungrige Bienen, denen der „Treibstoff“ ausgeht, andere Bienen zwischendurch gern mal um Honig an. Dieses Prinzip ließe sich durchaus auf E-Autos übertragen: Wenn Wagen mit leerem Akku an Fahrzeuge mit voller Batterie andockten. Nicht nur im Stau auf der Autobahn wäre dies äußerst nützlich. (vdo)