-

shutterstock.com©NicoEINino

05.10.2023Bewusst voreingenommen

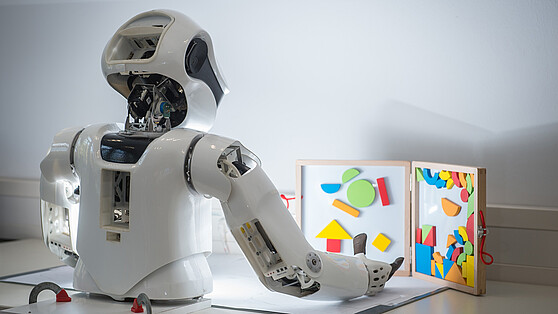

Wie wirken sich vorurteilsgeprägte Trainingsdaten auf die Antworten von Künstlicher Intelligenz aus? Das untersuchen Forschende der Humboldt-Universität zu Berlin in dem Projekt „OpinionGPT“. Browserbasiert kann jeder das bewusst tendenziös angelegte KI-Sprachmodell jetzt selbst testen.

Wie können wir den Klimawandel stoppen? „Ich denke, der beste Weg, den Klimawandel aufzuhalten, ist, die Verbrennung fossiler Brennstoffe einzustellen“, antwortet die imaginäre Person aus Deutschland. „Das können wir nicht. Es ist ein natürlicher Kreislauf“, so die Meinung aus den USA. Und die asiatische Variante lautet: „Ich denke, die einzige Möglichkeit, den Klimawandel aufzuhalten, besteht darin, nicht mehr Mensch zu sein.“ Drei unterschiedliche Antworten auf ein und dieselbe Frage. Und jede spiegelt eine andere Einstellung wider. Generiert wurde sie über das KI-Sprachmodell „OpinionGPT“.

In dem gleichnamigen Projekt untersucht eine Gruppe von Forschenden am Lehrstuhl Maschinelles Lernen am Institut für Informatik der Humboldt-Universität zu Berlin (HU Berlin), wie sich Voreingenommenheiten (Englisch „bias“) über die eingefütterten Trainingsdaten auf die Antworten eines KI-Modells auswirken. Dafür identifizierten die Forscherinnen und Forscher elf verschiedene demographische Gruppen, die vier Dimensionen zugeordnet wurden: Geschlecht (männlich/weiblich), Alter (Teenager, Personen über 30 Jahre, Rentnerinnen und Rentner), Herkunft (Deutschland, Amerika, Lateinamerika, Naher Osten) und politische Ausrichtung (links- oder rechtsorientiert). Für jede Dimension samt ihrer demographischen Untergruppen wurde anschließend ein Trainingskorpus von Frage-Antwort-Paaren erstellt. Die Antworten verfassten dabei jeweils Personen, die sich zu der entsprechenden Gruppierung zählten.

Ziel des Projekts ist es, ein Sprachmodell zu entwickeln, das Vorurteile gezielt abbildet. Eine browserbasierte Online-Demo macht die Auswirkung der voreingenommenen Trainingsdaten auf die Modellantworten transparent. Nutzerinnen und Nutzer können Fragen eingeben und die von der KI generierten, einander gegenübergestellten Modellantworten verschiedener demografischer Gruppen vergleichen. OpinionGPT ermöglicht Forschenden so, die Entstehung und Verbreitung von Vorurteilen in einer kontrollierten Umgebung zu untersuchen. Gleichzeitig verfolgt das Projekt einen kritischen Ansatz, denn es verdeutlicht, wie künstliche Intelligenz Stereotype verstärken und zur Verbreitung von Desinformation beitragen kann.

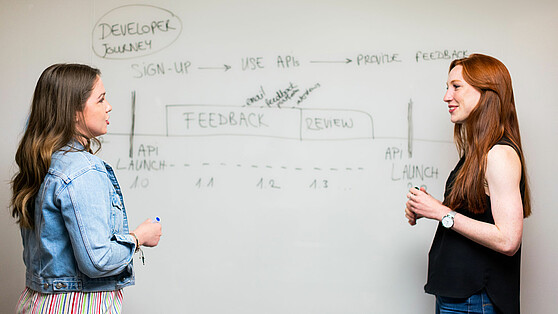

Und wie geht es weiter mit OpinionGPT? Die Forschenden am Lehrstuhl Maschinelles Lernen der HU Berlin wollen das Modell weiter verbessern. Unter anderem sollen die „Voreingenommenheiten“ in den Fragen und Antworten differenzierter ausmodelliert werden. Darüber hinaus sollen andere Wissenschaftlerinnen und Wissenschaftler über eine API-Schnittstelle direkten Zugang zu den Modellantworten erhalten. (vdo)

Weiterführende Informationen

Mehr Stories

-

Facts & Events

© Charité | Arne Sattler

Facts & EventsMedizinische Innovationen schneller voranbringen: Neues ARC-Zentrum bündelt Expertise.→

© Charité | Arne Sattler

Facts & EventsMedizinische Innovationen schneller voranbringen: Neues ARC-Zentrum bündelt Expertise.→Medizinische Innovationen schneller voranbringen: Neues ARC-Zentrum bündelt Expertise

-

Talent Facts & Events

© WISTA Management GmbH

Talent Facts & EventsDissertationspreis Adlershof 2025 geht an Nachwuchswissenschaftler Dr. Sascha Robert Gaudlitz.→

© WISTA Management GmbH

Talent Facts & EventsDissertationspreis Adlershof 2025 geht an Nachwuchswissenschaftler Dr. Sascha Robert Gaudlitz.→Dissertationspreis Adlershof 2025 geht an Nachwuchswissenschaftler Dr. Sascha Robert Gaudlitz

-

Facts & Events

© Berlin Partner. Copyright: Wüstenhagen

Facts & EventsWeltkrebstag 2026: Wie Berliner Forschung die Frauengesundheit stärkt.→

© Berlin Partner. Copyright: Wüstenhagen

Facts & EventsWeltkrebstag 2026: Wie Berliner Forschung die Frauengesundheit stärkt.→Weltkrebstag 2026: Wie Berliner Forschung die Frauengesundheit stärkt

-

Facts & Events

Bild von Fionn Grosse via Unsplash

Facts & EventsStadtentwicklungskongress 2026: Welche Visionen treiben die Städte von morgen an?→

Bild von Fionn Grosse via Unsplash

Facts & EventsStadtentwicklungskongress 2026: Welche Visionen treiben die Städte von morgen an?→Stadtentwicklungskongress 2026: Welche Visionen treiben die Städte von morgen an?

-

Facts & Events

© Terrartives, Crete, Greece

Facts & EventsKlimaschutz, wo andere Urlaub machen: Wie Berliner Forschung den Mittelmeerraum resilienter macht.→

© Terrartives, Crete, Greece

Facts & EventsKlimaschutz, wo andere Urlaub machen: Wie Berliner Forschung den Mittelmeerraum resilienter macht.→Klimaschutz, wo andere Urlaub machen: Wie Berliner Forschung den Mittelmeerraum resilienter macht

-

Startup Facts & Events

Bildnachweis: © Samuel Stuart Hollenshead / NYU Photo Bureau

Startup Facts & EventsNew York University wird strategische Partneruniversität der Humboldt-Universität.→

Bildnachweis: © Samuel Stuart Hollenshead / NYU Photo Bureau

Startup Facts & EventsNew York University wird strategische Partneruniversität der Humboldt-Universität.→New York University wird strategische Partneruniversität der Humboldt-Universität

-

Stories categories Facts & Events

© Berliner Partner. Urheber: Eventfotografen Berlin

Stories categories Facts & EventsAusblick: Das wird 2026 in der Berliner Wissenschaft wichtig.→

© Berliner Partner. Urheber: Eventfotografen Berlin

Stories categories Facts & EventsAusblick: Das wird 2026 in der Berliner Wissenschaft wichtig.→Ausblick: Das wird 2026 in der Berliner Wissenschaft wichtig

-

Insights Facts & Events

© Bundespreis Ecodesign. Urheber/in: IDZ Berlin

Insights Facts & Events„Mach Moor – Design mit Paludikultur“: Ausstellung zum Moorschutz in Berlin.→

© Bundespreis Ecodesign. Urheber/in: IDZ Berlin

Insights Facts & Events„Mach Moor – Design mit Paludikultur“: Ausstellung zum Moorschutz in Berlin.→„Mach Moor – Design mit Paludikultur“: Ausstellung zum Moorschutz in Berlin

-

Facts & Events

© Christop Sapp (denXte)

Facts & EventsProf. Dr. Barbara Vetter von der FU Berlin und Prof. Dr. Klaus-Robert Müller von der TU Berlin erhalten den wichtigsten deutschen…→

© Christop Sapp (denXte)

Facts & EventsProf. Dr. Barbara Vetter von der FU Berlin und Prof. Dr. Klaus-Robert Müller von der TU Berlin erhalten den wichtigsten deutschen…→Leibniz-Preise für Philosophin und Informatiker aus Berlin

-

Facts & Events Transfer – Stories

© Agentur Medienlabor / Stefan Schubert

Facts & Events Transfer – StoriesFünf Unternehmen aus der Hauptstadtregion wurden für ihre visionären Ideen und Produkte ausgezeichnet, ein weiteres erhielt den Sonderpreis.→

© Agentur Medienlabor / Stefan Schubert

Facts & Events Transfer – StoriesFünf Unternehmen aus der Hauptstadtregion wurden für ihre visionären Ideen und Produkte ausgezeichnet, ein weiteres erhielt den Sonderpreis.→Innovationspreis Berlin Brandenburg 2025 – die Gewinner

-

Facts & Events

© Berlin Partner / Wüstenhagen

Facts & EventsDie Zusammenarbeit zwischen Wissenschaft und Wirtschaft steht vom 24. bis zum 28. November 2025 wieder im Fokus der Transfer Week Berlin-Brandenburg.→

© Berlin Partner / Wüstenhagen

Facts & EventsDie Zusammenarbeit zwischen Wissenschaft und Wirtschaft steht vom 24. bis zum 28. November 2025 wieder im Fokus der Transfer Week Berlin-Brandenburg.→Transfer Week Berlin-Brandenburg 2025

-

Facts & Events

© Berlin Partner / Elvina Kulinicenko

Facts & EventsIm Oktober/November fiel der Startschuss für den Bau von gleich drei prominenten Forschungsgebäuden in Berlin, ein weiteres wurde eröffnet. Ein…→

© Berlin Partner / Elvina Kulinicenko

Facts & EventsIm Oktober/November fiel der Startschuss für den Bau von gleich drei prominenten Forschungsgebäuden in Berlin, ein weiteres wurde eröffnet. Ein…→Schaufenster, Hubs und Innovationsplattformen: Was ist neu in der Brain City Berlin?

-

Facts & Events

Berlin Science Week 2025 © Design: Bjoern Wolf / Graphic: Martin Naumann

Facts & EventsVom 1. bis zum 10. November lädt die Berlin Science Week wieder dazu ein, die Brain City Berlin zu erkunden. Das diesjährige Motto „Beyond Now“.→

Berlin Science Week 2025 © Design: Bjoern Wolf / Graphic: Martin Naumann

Facts & EventsVom 1. bis zum 10. November lädt die Berlin Science Week wieder dazu ein, die Brain City Berlin zu erkunden. Das diesjährige Motto „Beyond Now“.→Neue Perspektiven eröffnen: Berlin Science Week 2025

-

Facts & Events

© Berlin University Alliance

Facts & EventsAb dem 10. Oktober 2025 präsentiert die Ausstellung „On Water. WasserWissen in Berlin“ im Humboldt Labor ganz neue Perspektiven auf das Element…→

© Berlin University Alliance

Facts & EventsAb dem 10. Oktober 2025 präsentiert die Ausstellung „On Water. WasserWissen in Berlin“ im Humboldt Labor ganz neue Perspektiven auf das Element…→„On Water“: Wasser neu denken

-

Facts & Events Transfer – Stories

© Christian Kielmann

Facts & Events Transfer – StoriesAuf dem Campus der TU Berlin entsteht die europaweit größte Laborinfrastruktur für Transferteams im Bereich der Grünen Chemie. Die „Chemical Invention…→

© Christian Kielmann

Facts & Events Transfer – StoriesAuf dem Campus der TU Berlin entsteht die europaweit größte Laborinfrastruktur für Transferteams im Bereich der Grünen Chemie. Die „Chemical Invention…→Spatenstich für „Chemical Invention Factory“

-

Insights Facts & Events

© Matters of Activity / HU Berlin

Insights Facts & EventsAm 19. September veranstaltet das Exzellenzcluster „Matters of Activity" seine Jahreskonferenz. Brain City Interview mit Dr. Christian Stein.→

© Matters of Activity / HU Berlin

Insights Facts & EventsAm 19. September veranstaltet das Exzellenzcluster „Matters of Activity" seine Jahreskonferenz. Brain City Interview mit Dr. Christian Stein.→„Wir bringen das Material auf Augenhöhe“

-

Facts & Events

© Graziela Diez

Facts & EventsMit ihrem Projekt „Data Worker’s Inquiry“ macht die Berliner Soziologin und Informatikerin auf Missstände in der KI-Arbeit aufmerksam.→

© Graziela Diez

Facts & EventsMit ihrem Projekt „Data Worker’s Inquiry“ macht die Berliner Soziologin und Informatikerin auf Missstände in der KI-Arbeit aufmerksam.→Dr. Milagros Miceli auf TIME-100-Liste der einflussreichsten Menschen im KI-Bereich

-

Facts & Events Transfer – Stories

© Tu Berlin / allefarben-foto

Facts & Events Transfer – StoriesDrohnen-Logistik, Baustoff-Recycling und Wiederverwendung von Abwasser: Diese drei Ideen sollen in den kommenden drei Jahren in Reallaboren praxisnah…→

© Tu Berlin / allefarben-foto

Facts & Events Transfer – StoriesDrohnen-Logistik, Baustoff-Recycling und Wiederverwendung von Abwasser: Diese drei Ideen sollen in den kommenden drei Jahren in Reallaboren praxisnah…→Drei Berliner Reallabore gehen an den Start

-

Facts & Events

© mfn / Carola Radke

Facts & EventsAm 6. Oktober lädt das Team von mit:forschen! zum ersten Campus Citizen Science ins Museum für Naturkunde Berlin ein.→

© mfn / Carola Radke

Facts & EventsAm 6. Oktober lädt das Team von mit:forschen! zum ersten Campus Citizen Science ins Museum für Naturkunde Berlin ein.→Campus Citizen Science: Künstliche Intelligenz

-

Facts & Events Transfer – Stories

© Stefan Klenke / HU Berlin

Facts & Events Transfer – StoriesDer Berliner Batterieforscher Prof. Dr. Philipp Adelhelm ist mit dem Wissenschaftspreis 2024 des Regierenden Bürgermeisters von Berlin ausgezeichnet…→

© Stefan Klenke / HU Berlin

Facts & Events Transfer – StoriesDer Berliner Batterieforscher Prof. Dr. Philipp Adelhelm ist mit dem Wissenschaftspreis 2024 des Regierenden Bürgermeisters von Berlin ausgezeichnet…→Berliner Wissenschaftspreis für Prof. Dr. Philipp Adelhelm

-

Insights Facts & Events

© Ernestine von der Osten-Sacken

Insights Facts & EventsEs geht um die Ernährung der Zukunft: Im Verbundprojekt CUBES Circle erforschen Wissenschaftlerinnen und Wissenschaftler, wie etablierte…→

© Ernestine von der Osten-Sacken

Insights Facts & EventsEs geht um die Ernährung der Zukunft: Im Verbundprojekt CUBES Circle erforschen Wissenschaftlerinnen und Wissenschaftler, wie etablierte…→Tomaten und Fische im Zero-Waste-Kreislauf

-

Facts & Events

© BHT / Simone M. Neumann

Facts & EventsHier gleich drei aktuelle News, in denen unsere Brain City Botschafterinnen und Botschafter eine tragende Rolle spielen.→

© BHT / Simone M. Neumann

Facts & EventsHier gleich drei aktuelle News, in denen unsere Brain City Botschafterinnen und Botschafter eine tragende Rolle spielen.→UNITE und mehr: 3 x Neues

-

Facts & Events

© Pelin Asa, Matters of Activity / Max Planck Institute of Colloids and Interfaces

Facts & EventsDie Ausstellungen „Symbiotic Wood“ und „Swamp Things!“ des Exzellenzcluster „Matters of Activity“ betrachten Käferfraß, Pilzbefall und scheinbar…→

© Pelin Asa, Matters of Activity / Max Planck Institute of Colloids and Interfaces

Facts & EventsDie Ausstellungen „Symbiotic Wood“ und „Swamp Things!“ des Exzellenzcluster „Matters of Activity“ betrachten Käferfraß, Pilzbefall und scheinbar…→Inspiriert von Käfern und Moorpflanzen

-

Facts & Events

© LNDW

Facts & EventsDie LNDW feiert in diesem Jahr Jubiläum. Auf dem Programm stehen mehr als 1.000 Veranstaltungen. Tickets gibt’s zum Sonderpreis von 5 Euro!→

© LNDW

Facts & EventsDie LNDW feiert in diesem Jahr Jubiläum. Auf dem Programm stehen mehr als 1.000 Veranstaltungen. Tickets gibt’s zum Sonderpreis von 5 Euro!→25 Jahre Lange Nacht der Wissenschaften

-

Facts & Events

© Berlin University Alliance / Matthias Heyde

Facts & EventsDie Entscheidung ist gefallen: Die Brain City Berlin geht mit fünf Forschungs-Clustern in die nächste Runde der Exzellenzförderung von Bund und…→

© Berlin University Alliance / Matthias Heyde

Facts & EventsDie Entscheidung ist gefallen: Die Brain City Berlin geht mit fünf Forschungs-Clustern in die nächste Runde der Exzellenzförderung von Bund und…→Exzellenzstrategie: Berlin künftig mit 5 Clustern dabei

-

Facts & Events

© Ilja C Hendel / Wissenschaft im Dialog

Facts & EventsEs ist wieder so weit: Das Ausstellungsschiff ist erneut auf deutschen Gewässern unterwegs. 29 Städte stehen in diesem Jahr auf dem Programm.→

© Ilja C Hendel / Wissenschaft im Dialog

Facts & EventsEs ist wieder so weit: Das Ausstellungsschiff ist erneut auf deutschen Gewässern unterwegs. 29 Städte stehen in diesem Jahr auf dem Programm.→Ahoi! MS Wissenschaft on Tour 2025

-

Facts & Events Transfer – Stories

© DLR (CC BY-NC-ND 3.0)

Facts & Events Transfer – StoriesMit dem Anfang Mai gegründeten Institut bündelt das Deutsche Zentrum für Luft- und Raumfahrt in Berlin Adlershof seine Expertise auf dem Gebiet der…→

© DLR (CC BY-NC-ND 3.0)

Facts & Events Transfer – StoriesMit dem Anfang Mai gegründeten Institut bündelt das Deutsche Zentrum für Luft- und Raumfahrt in Berlin Adlershof seine Expertise auf dem Gebiet der…→Neues DLR-Institut für Weltraumforschung

-

Facts & Events

© TU Berlin / Ulrich Dahl

Facts & EventsDie TU Berlin beteiligt sich mit dem Verlag BerlinUP aktiv am Aufbau der nationalen Servicestelle für Diamond Open Access (SeDOA).→

© TU Berlin / Ulrich Dahl

Facts & EventsDie TU Berlin beteiligt sich mit dem Verlag BerlinUP aktiv am Aufbau der nationalen Servicestelle für Diamond Open Access (SeDOA).→Offene Wissenschaft stärken

-

Facts & Events

© Agentur Medienlabor / Stefan Schubert

Facts & EventsGesucht werden auch in diesem Jahr Produkte, Konzepte und Lösungen, die für die Innovationskraft der Hauptstadtregion stehen.→

© Agentur Medienlabor / Stefan Schubert

Facts & EventsGesucht werden auch in diesem Jahr Produkte, Konzepte und Lösungen, die für die Innovationskraft der Hauptstadtregion stehen.→Innovationspreis Berlin Brandenburg 2025: bis 14. Juli bewerben!

-

Facts & Events

© Frank Richtersmeier

Facts & EventsDen österliche Spaziergang mit einem guten Zweck verbinden: Unsere Citizen-Science-Favoriten für die Feiertage.→

© Frank Richtersmeier

Facts & EventsDen österliche Spaziergang mit einem guten Zweck verbinden: Unsere Citizen-Science-Favoriten für die Feiertage.→Meister Lampe und Schmetterlinge – zu Ostern die Natur erkunden!

-

Facts & Events

© Robin Baumgarten

Facts & EventsAm 14. April feiert die Urania Berlin den World Quantum Day – und damit 100 Jahre Quantenphysik. Veranstalterin ist die Deutsche Physikalische…→

© Robin Baumgarten

Facts & EventsAm 14. April feiert die Urania Berlin den World Quantum Day – und damit 100 Jahre Quantenphysik. Veranstalterin ist die Deutsche Physikalische…→World Quantum Day 2025: Quantenforschung zum Mitmachen

-

Facts & Events

© Institut für Geschichte der Medizin und Ethik der Medizin, Charité (IGM-K-HPAC 3086-1908)

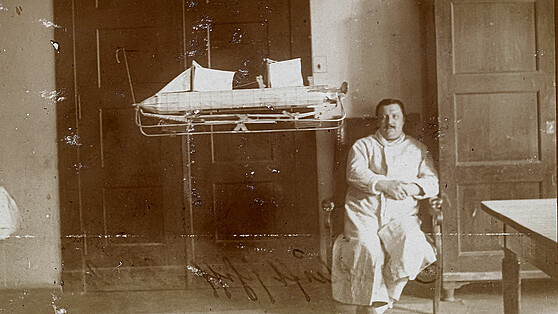

Facts & EventsIn der Ausstellung „Erfindungswahn!“ erzählt das Berliner Medizinhistorische Museum der Charité die Geschichte des „Ingenieurs von Tarden“ und seines…→

© Institut für Geschichte der Medizin und Ethik der Medizin, Charité (IGM-K-HPAC 3086-1908)

Facts & EventsIn der Ausstellung „Erfindungswahn!“ erzählt das Berliner Medizinhistorische Museum der Charité die Geschichte des „Ingenieurs von Tarden“ und seines…→Erfindungswahn – der Traum vom Fliegen

-

Facts & Events

Prof. Dr. Volker Haucke: FMP © Silke Oßwald; Prof. Dr. Ana Prombo: MDC © Pablo Castagnola

Facts & EventsProf. Dr. Ana Pombo (MDC) and Prof. Dr. Volker Haucke (FMP) haben den Gottfried-Wilhelm-Leibniz-Preis 2025 erhalten.→

Prof. Dr. Volker Haucke: FMP © Silke Oßwald; Prof. Dr. Ana Prombo: MDC © Pablo Castagnola

Facts & EventsProf. Dr. Ana Pombo (MDC) and Prof. Dr. Volker Haucke (FMP) haben den Gottfried-Wilhelm-Leibniz-Preis 2025 erhalten.→Leibniz-Preis für 2 Berliner Spitzenforschende

-

Facts & Events Transfer – Stories

© Berlin Partner / eventfotografen.berlin

Facts & Events Transfer – StoriesAnfang März haben insgesamt 19 Universitäten, Hochschulen und außeruniversitäre Forschungseinrichtungen die Satzung von UNITE Sciences e.V.…→

© Berlin Partner / eventfotografen.berlin

Facts & Events Transfer – StoriesAnfang März haben insgesamt 19 Universitäten, Hochschulen und außeruniversitäre Forschungseinrichtungen die Satzung von UNITE Sciences e.V.…→UNITE Sciences: Technologietransfer beschleunigen

-

Facts & Events

© ZAUM / Christine Weil

Facts & EventsEine Forschungsgruppe der Charité – Universitätsmedizin Berlin hat eine App entwickelt, mit der sich der Pollenflug auf drei Stunden genau…→

© ZAUM / Christine Weil

Facts & EventsEine Forschungsgruppe der Charité – Universitätsmedizin Berlin hat eine App entwickelt, mit der sich der Pollenflug auf drei Stunden genau…→Charité-App „Pollenius“: Citizen Science & Daten aus der Pollenfalle

-

Facts & Events

© HTW Berlin/ Alexander Rentsch

Facts & EventsMit 51 Prozent verzeichnet die Brain City Berlin die höchste Quote an Hochschul-Erstabsolventinnen und -absolventen in Deutschland.→

© HTW Berlin/ Alexander Rentsch

Facts & EventsMit 51 Prozent verzeichnet die Brain City Berlin die höchste Quote an Hochschul-Erstabsolventinnen und -absolventen in Deutschland.→Studienerstabschlüsse: Berlin 2023 bundesweit in Spitzenposition

-

Facts & Events

© Shutterstock/Sineeho

Facts & EventsForschende des Max-Planck-Instituts für Bildungsforschung haben in einer Metaanalyse untersucht, wer besonders anfällig für online gestreute…→

© Shutterstock/Sineeho

Facts & EventsForschende des Max-Planck-Instituts für Bildungsforschung haben in einer Metaanalyse untersucht, wer besonders anfällig für online gestreute…→Fake News: Wer fällt warum darauf rein?

-

Facts & Events

© UdK Berlin / Design: Ira Göller und Sophie Pischel

Facts & EventsAm 8. Februar startet die Universität der Künste Berlin in ihr Jubiläumsjahr. Mit fachbereichsübergreifenden Performances, Tanz, Theater,…→

© UdK Berlin / Design: Ira Göller und Sophie Pischel

Facts & EventsAm 8. Februar startet die Universität der Künste Berlin in ihr Jubiläumsjahr. Mit fachbereichsübergreifenden Performances, Tanz, Theater,…→50 Jahre: UdK Berlin feiert Vielfalt ihrer Disziplinen

-

Facts & Events Transfer – Stories

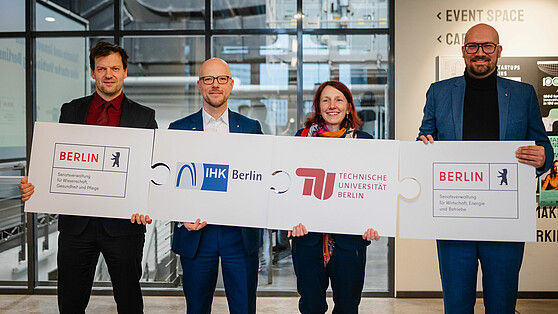

© IHK Berlin

Facts & Events Transfer – StoriesHochschulausgründungen und Innovationen wollen TU Berlin und IHK Berlin künftig gemeinsam stärker voranbringen. Eine entsprechende Vereinbarung wurde…→

© IHK Berlin

Facts & Events Transfer – StoriesHochschulausgründungen und Innovationen wollen TU Berlin und IHK Berlin künftig gemeinsam stärker voranbringen. Eine entsprechende Vereinbarung wurde…→Kooperation zwischen TU Berlin und IHK Berlin

-

Facts & Events

© Shutterstock. AI Generator

Facts & EventsSind feste Beziehungen wichtiger für Frauen oder für Männer? Eine Studie, an der das Institut für Psychologie der HU Berlin federführend beteiligt…→

© Shutterstock. AI Generator

Facts & EventsSind feste Beziehungen wichtiger für Frauen oder für Männer? Eine Studie, an der das Institut für Psychologie der HU Berlin federführend beteiligt…→Romantischer Gender-Gap

-

Facts & Events

© LNDW/Matthias Frank

Facts & Events200 Jahre Museumsinsel, 100 Jahre Quantenwissenschaft, 50 Jahre UdK Berlin, 25 Jahre LNDW: 2025 feiert die Brain City Berlin gleich mehrere Jubiläen.→

© LNDW/Matthias Frank

Facts & Events200 Jahre Museumsinsel, 100 Jahre Quantenwissenschaft, 50 Jahre UdK Berlin, 25 Jahre LNDW: 2025 feiert die Brain City Berlin gleich mehrere Jubiläen.→Brain City Berlin 2025: unsere Top-10

-

Facts & Events

© Agentur Medienlabor | Stefan Schubert

Facts & EventsDie Preisträgerinnen und Preisträger des Innovationspreises Berlin Brandenburg 2024 stehen fest. Insgesamt 125 Bewerbungen gingen in diesem Jahr ein.…→

© Agentur Medienlabor | Stefan Schubert

Facts & EventsDie Preisträgerinnen und Preisträger des Innovationspreises Berlin Brandenburg 2024 stehen fest. Insgesamt 125 Bewerbungen gingen in diesem Jahr ein.…→Innovationspreis Berlin Brandenburg 2024

-

Facts & Events Transfer – Stories

© Berlin Partner

Facts & Events Transfer – StoriesAuf der vierten Transfer Week Berlin-Brandenburg vom 25. bis zum 29. November geht um neueste Entwicklungen im regionalen Transfergeschehen. 62…→

© Berlin Partner

Facts & Events Transfer – StoriesAuf der vierten Transfer Week Berlin-Brandenburg vom 25. bis zum 29. November geht um neueste Entwicklungen im regionalen Transfergeschehen. 62…→Zukunft des Wissenstransfers: Transfer Week 2024

-

Facts & Events

© Falling Walls Foundation

Facts & EventsVom 1. bis zum 10. November steht die Brain City Berlin wieder weltweit im Spotlight. Das vielfältige Programm der 9. Berlin Science Week umfasst mehr…→

© Falling Walls Foundation

Facts & EventsVom 1. bis zum 10. November steht die Brain City Berlin wieder weltweit im Spotlight. Das vielfältige Programm der 9. Berlin Science Week umfasst mehr…→Gemeinsame Wege finden: Berlin Science Week 2024

-

Facts & Events Transfer – Stories

© CeRRI 2024

Facts & Events Transfer – StoriesTransferaktivitäten und Forschung konkurrieren nicht miteinander. Im Gegenteil! Das ist ein Kernergebnis der Studie „Transfer 1000“ von TU Berlin und…→

© CeRRI 2024

Facts & Events Transfer – StoriesTransferaktivitäten und Forschung konkurrieren nicht miteinander. Im Gegenteil! Das ist ein Kernergebnis der Studie „Transfer 1000“ von TU Berlin und…→„Transfer 1000“: Studie zum Wissenschaftstransfer

-

Facts & Events Transfer – Stories

© HTW/ZfS

Facts & Events Transfer – StoriesKlima, Gesundheit und Nachhaltigkeit – das sind die Kernthemen der Transferale. Vom 25. bis zum 27. September findet das Wissenschafts- und…→

© HTW/ZfS

Facts & Events Transfer – StoriesKlima, Gesundheit und Nachhaltigkeit – das sind die Kernthemen der Transferale. Vom 25. bis zum 27. September findet das Wissenschafts- und…→Ideen für Berlins Zukunft

-

Facts & Events

© Adobe Stock/stockartstudio

Facts & EventsDie Humboldt-Universität zu Berlin hat den Frauenanteil an den Professuren in rund 15 Jahren fast verdoppelt. Bei den wissenschaftlichen…→

© Adobe Stock/stockartstudio

Facts & EventsDie Humboldt-Universität zu Berlin hat den Frauenanteil an den Professuren in rund 15 Jahren fast verdoppelt. Bei den wissenschaftlichen…→HU Berlin: mehr Frauen in der Wissenschaft

-

Facts & Events

© Max Delbrück Center / Felix Petermann

Facts & EventsDr. Gabriele Schiattarella ist von der International Society for Heart Research mit dem „Outstanding Investigator Award“ gewürdigt worden. Der…→

© Max Delbrück Center / Felix Petermann

Facts & EventsDr. Gabriele Schiattarella ist von der International Society for Heart Research mit dem „Outstanding Investigator Award“ gewürdigt worden. Der…→Berliner Herzforscher ausgezeichnet

-

Facts & Events

firefly.adobe (AI-generated)

Facts & EventsEine Übersichts-Studie des GLEON-Netzwerks zeigt auf, welche Faktoren Blaualgen eindämmen können. Forschende des Berliner IGB waren daran beteiligt.→

firefly.adobe (AI-generated)

Facts & EventsEine Übersichts-Studie des GLEON-Netzwerks zeigt auf, welche Faktoren Blaualgen eindämmen können. Forschende des Berliner IGB waren daran beteiligt.→Starkregen, Fische und Bakterien: Was stoppt Blaualgen?

-

Facts & Events

© TU Berlin / Philipp Arnoldt

Facts & EventsIn der gemeinsamen Bibliothek von TU Berlin und UdK Berlin wird dies ab 2025 möglich sein. Der Berliner Senat hat dem Modellprojekt zugestimmt.→

© TU Berlin / Philipp Arnoldt

Facts & EventsIn der gemeinsamen Bibliothek von TU Berlin und UdK Berlin wird dies ab 2025 möglich sein. Der Berliner Senat hat dem Modellprojekt zugestimmt.→Lernen in der Uni-Bibliothek bald 24/7

-

Facts & Events

© Max Delbrück Center / Stefanie Loos

Facts & EventsAm Abend des 22. Juni präsentiert sich die Brain City Berlin wieder in ihrer ganzen Vielfalt. Das Motto der LNDW 2024: „Erleben. Verstehen. Wissen.“→

© Max Delbrück Center / Stefanie Loos

Facts & EventsAm Abend des 22. Juni präsentiert sich die Brain City Berlin wieder in ihrer ganzen Vielfalt. Das Motto der LNDW 2024: „Erleben. Verstehen. Wissen.“→Lange Nacht der Wissenschaften 2024

-

Facts & Events

© Landesarchiv Berlin/Wunstorf

Facts & EventsDie Sprachwissenschaftlerin wurde am 27. Mai im Roten Rathaus vom Regierenden Bürgermeister, Kai Wegner, ausgezeichnet. Der Nachwuchspreis ging an Dr.…→

© Landesarchiv Berlin/Wunstorf

Facts & EventsDie Sprachwissenschaftlerin wurde am 27. Mai im Roten Rathaus vom Regierenden Bürgermeister, Kai Wegner, ausgezeichnet. Der Nachwuchspreis ging an Dr.…→Berliner Wissenschaftspreis 2023 für Artemis Alexiadou

-

Facts & Events

© mit:forschen!

Facts & EventsNoch bis zum 3. Juni können Wissenschaftlerinnen und Wissenschaftler aller Disziplinen für den „Wissen der Vielen – Forschungspreis für Citizen…→

© mit:forschen!

Facts & EventsNoch bis zum 3. Juni können Wissenschaftlerinnen und Wissenschaftler aller Disziplinen für den „Wissen der Vielen – Forschungspreis für Citizen…→Gesucht: Exzellente Publikationen zu bürgerwissenschaftlicher Forschung

-

Facts & Events

© HWR Berlin/Lukas Schramm

Facts & EventsStudieren – ja. Doch an welcher Hochschule? Und vor allem: welches Fach? Auch in diesem Jahr laden die Berliner Universitäten und Hochschulen wieder…→

© HWR Berlin/Lukas Schramm

Facts & EventsStudieren – ja. Doch an welcher Hochschule? Und vor allem: welches Fach? Auch in diesem Jahr laden die Berliner Universitäten und Hochschulen wieder…→Studieninfotage 2024

-

Facts & Events

© Berlin University Alliance

Facts & Events„Das offene Wissenslabor – für die großen Transformationen unserer Zeit“: Mit ihrer neuen Kampagne macht die Berlin University Alliance…→

© Berlin University Alliance

Facts & Events„Das offene Wissenslabor – für die großen Transformationen unserer Zeit“: Mit ihrer neuen Kampagne macht die Berlin University Alliance…→Berlin University Alliance launcht neue Kampagne

-

Facts & Events

© Retusche: Ralitsa Kirova/Wissenschaft im Dialog CCBY-SA4.0

Facts & EventsAm 14. Mai begibt sich das schwimmende Science Center „MS Wissenschaft“ mit einer interaktiven Ausstellung zum Thema „Freiheit“ erneut auf große Fahrt…→

© Retusche: Ralitsa Kirova/Wissenschaft im Dialog CCBY-SA4.0

Facts & EventsAm 14. Mai begibt sich das schwimmende Science Center „MS Wissenschaft“ mit einer interaktiven Ausstellung zum Thema „Freiheit“ erneut auf große Fahrt…→Leinen los! MS Wissenschaft wieder auf Tour

-

Facts & Events

© Agentur Medienlabor

Facts & EventsDie Bewerbungsphase ist eröffnet: Bis zum 8. Juli können Unternehmen, Start-ups und Handwerksbetriebe mit Sitz in der Brain City Berlin oder in…→

© Agentur Medienlabor

Facts & EventsDie Bewerbungsphase ist eröffnet: Bis zum 8. Juli können Unternehmen, Start-ups und Handwerksbetriebe mit Sitz in der Brain City Berlin oder in…→Startschuss für Innovationspreis Berlin Brandenburg 2024

-

Facts & Events

xg-incubator.com

Facts & EventsNoch bis zum 31. März können Start-ups und Gründer:innen ihre Unterlagen für den neuen xG-Incubator von TU Berlin und Fraunhofer HHI einreichen.→

xg-incubator.com

Facts & EventsNoch bis zum 31. März können Start-ups und Gründer:innen ihre Unterlagen für den neuen xG-Incubator von TU Berlin und Fraunhofer HHI einreichen.→Jetzt bewerben! Ideen für die Zukunft der Kommunikation

-

Facts & Events

Shutterstock © LightField Studios

Facts & EventsHU Berlin, TU Berlin, ASH Berlin, BHT und HfS Ernst Busch – diese Berliner Hochschulen sind in der ersten Runde des Professorinnenprogramms 2030 der…→

Shutterstock © LightField Studios

Facts & EventsHU Berlin, TU Berlin, ASH Berlin, BHT und HfS Ernst Busch – diese Berliner Hochschulen sind in der ersten Runde des Professorinnenprogramms 2030 der…→Professorinnenprogramm 2030: fünf Berliner Hochschulen ausgewählt

-

Facts & Events

© HTW Berlin/Chris Hartung

Facts & EventsVom 12. bis zum 16. Februar laden die Career Services der Universitäten und Hochschulen in Berlin und Brandenburg zur ersten gemeinsamen Career Week…→

© HTW Berlin/Chris Hartung

Facts & EventsVom 12. bis zum 16. Februar laden die Career Services der Universitäten und Hochschulen in Berlin und Brandenburg zur ersten gemeinsamen Career Week…→Tipps und Infos zum Berufseinstieg

-

Facts & Events Transfer – Stories

TU Berlin © Felix Noak

Facts & Events Transfer – StoriesNoch bis zum 29. April können interdisziplinäre Forschungsteams Proposals für die Next Grand Challenge der Berlin University Alliance einreichen.→

TU Berlin © Felix Noak

Facts & Events Transfer – StoriesNoch bis zum 29. April können interdisziplinäre Forschungsteams Proposals für die Next Grand Challenge der Berlin University Alliance einreichen.→Next Grand Challenge: jetzt bewerben!

-

Facts & Events

LNDW / Freie Universität Berlin © Rolf Schulten

Facts & EventsFreiheit, Zeit oder Wissenstransfer – auch 2024 stehen im Veranstaltungskalender der Brain City Berlin wieder viele spannende Themen und Events.→

LNDW / Freie Universität Berlin © Rolf Schulten

Facts & EventsFreiheit, Zeit oder Wissenstransfer – auch 2024 stehen im Veranstaltungskalender der Brain City Berlin wieder viele spannende Themen und Events.→Brain City Berlin 2024: unsere Top-10

-

Facts & Events Transfer – Stories

© Alfred-Wegener-Institut/Micheal Gutsche (CC-BY 4.0)

Facts & Events Transfer – StoriesEine Sonderausstellung im Deutschen Technikmuseum macht eiswürfelklar: Es bleibt nur noch wenig Zeit, um die Arktis zu retten.→

© Alfred-Wegener-Institut/Micheal Gutsche (CC-BY 4.0)

Facts & Events Transfer – StoriesEine Sonderausstellung im Deutschen Technikmuseum macht eiswürfelklar: Es bleibt nur noch wenig Zeit, um die Arktis zu retten.→Ausstellungstipp: „Dünnes Eis“

-

Facts & Events Transfer – Stories

© BPWT

Facts & Events Transfer – StoriesMit einer ganztägigen Auftaktkonferenz in den stilwerk KantGaragen geht die Transfer Week Berlin-Brandenburg 2023 an den Start.→

© BPWT

Facts & Events Transfer – StoriesMit einer ganztägigen Auftaktkonferenz in den stilwerk KantGaragen geht die Transfer Week Berlin-Brandenburg 2023 an den Start.→„Wissenschaft x Wirtschaft“: Transfer Week 2023

-

Facts & Events Transfer – Stories

© Falling Walls Foundation

Facts & Events Transfer – StoriesVom 1. bis zum 10. November ist wieder Berlin Science Week. Neu in diesem Jahr: Das ART & SCIENCE FORUM im Holzmarkt 25 ist neben dem CAMPUS im…→

© Falling Walls Foundation

Facts & Events Transfer – StoriesVom 1. bis zum 10. November ist wieder Berlin Science Week. Neu in diesem Jahr: Das ART & SCIENCE FORUM im Holzmarkt 25 ist neben dem CAMPUS im…→Mit Fokus auf Kunst & Wissenschaft: Berlin Science Week 2023

-

Facts & Events

© SPB/Natalie Toczek

Facts & Events100 Jahre Planetarium: Am 21. Oktober feiert das Berliner Zeiss-Großplanetarium das Sternenschau-Jubiläum mit einem bunten Programm aus Astronomie,…→

© SPB/Natalie Toczek

Facts & Events100 Jahre Planetarium: Am 21. Oktober feiert das Berliner Zeiss-Großplanetarium das Sternenschau-Jubiläum mit einem bunten Programm aus Astronomie,…→Umsonst ins All reisen

-

Facts & Events Transfer – Stories

© Peter Himsel/Campus Berlin-Buch GmbH

Facts & Events Transfer – StoriesDie Brain City Berlin hat ein neues Gründerzentrum: Der BerlinBioCube auf dem Campus Berlin-Buch umfasst 8.000 Quadratmeter moderne Labor- und…→

© Peter Himsel/Campus Berlin-Buch GmbH

Facts & Events Transfer – StoriesDie Brain City Berlin hat ein neues Gründerzentrum: Der BerlinBioCube auf dem Campus Berlin-Buch umfasst 8.000 Quadratmeter moderne Labor- und…→BerlinBioCube eröffnet

-

Facts & Events

© FU Berlin/Bernd Wannenmacher

Facts & Events„Oral-History.Digital“ heißt ein in dieser Woche online gegangenes Portal. Die Universitätsbibliothek der FU Berlin ist Partnerin des von der DFG…→

© FU Berlin/Bernd Wannenmacher

Facts & Events„Oral-History.Digital“ heißt ein in dieser Woche online gegangenes Portal. Die Universitätsbibliothek der FU Berlin ist Partnerin des von der DFG…→Neue-Plattform für Zeitzeugen-Interviews

-

Facts & Events Transfer – Stories

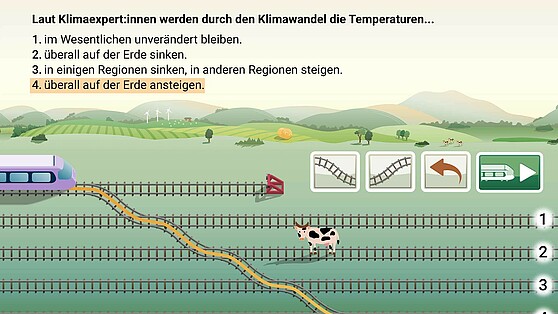

© HU Berlin

Facts & Events Transfer – StoriesDie App „TRAIN 4 Science“ regt Kinder, aber auch Erwachsene spielerisch dazu an, sich mit dem Klimawandel auseinanderzusetzen. Konzipiert und…→

© HU Berlin

Facts & Events Transfer – StoriesDie App „TRAIN 4 Science“ regt Kinder, aber auch Erwachsene spielerisch dazu an, sich mit dem Klimawandel auseinanderzusetzen. Konzipiert und…→Mit dem virtuellen Zug in eine nachhaltige Zukunft

-

Facts & Events

© DLR. Alle Rechte vorbehalten

Facts & EventsIm „DLR_School_LAB Online Observatory“ können Schülerinnen und Schüler jetzt deutschlandweit die Sonne live beobachten.→

© DLR. Alle Rechte vorbehalten

Facts & EventsIm „DLR_School_LAB Online Observatory“ können Schülerinnen und Schüler jetzt deutschlandweit die Sonne live beobachten.→Im Klassenzimmer zur Sonne reisen

-

Facts & Events

LNDM: Kulturprojekte © Christian Kielmann

Facts & EventsLangeweile in den Ferien? Die Brain City Berlin bietet jede Menge Abwechslung! Hier unsere Ferien-Favoriten.→

LNDM: Kulturprojekte © Christian Kielmann

Facts & EventsLangeweile in den Ferien? Die Brain City Berlin bietet jede Menge Abwechslung! Hier unsere Ferien-Favoriten.→10 Tipps für den Sommer

-

Facts & Events Transfer – Stories

© BHT/Zarko Martovic

Facts & Events Transfer – StoriesAm 17. Juni ist es wieder so weit: Mehr als 60 wissenschaftliche und wissenschaftsnahe Einrichtungen in der Brain City Berlin und Potsdam öffnen ihre…→

© BHT/Zarko Martovic

Facts & Events Transfer – StoriesAm 17. Juni ist es wieder so weit: Mehr als 60 wissenschaftliche und wissenschaftsnahe Einrichtungen in der Brain City Berlin und Potsdam öffnen ihre…→Lange Nacht der Wissenschaften 2023

-

Facts & Events

© FU Berlin / Svea Pietschmann

Facts & Events„Freies Denken. Verantwortung bilden. Veränderung gestalten.“ Unter diesem Motto feiert die Freie Universität Berlin in diesem Jahr ihren 75.…→

© FU Berlin / Svea Pietschmann

Facts & Events„Freies Denken. Verantwortung bilden. Veränderung gestalten.“ Unter diesem Motto feiert die Freie Universität Berlin in diesem Jahr ihren 75.…→75 Jahre Freie Universität Berlin

-

Facts & Events Transfer – Stories

© BSBI

Facts & Events Transfer – StoriesAm 24. Juni trifft sich die KI-Szene in Berlin-Neukölln. Auf der „1. Internationalen Konferenz für Künstliche Intelligenz“ an der BSBI geht es vor…→

© BSBI

Facts & Events Transfer – StoriesAm 24. Juni trifft sich die KI-Szene in Berlin-Neukölln. Auf der „1. Internationalen Konferenz für Künstliche Intelligenz“ an der BSBI geht es vor…→KI-Konferenz an der Berlin School of Business & Innovation

-

Facts & Events

© David Ausserhofer

Facts & EventsDer Nachwuchspreis ging an Dr. Anja Maria Wagemans – und damit ebenfalls an eine Forscherin der TU Berlin.→

© David Ausserhofer

Facts & EventsDer Nachwuchspreis ging an Dr. Anja Maria Wagemans – und damit ebenfalls an eine Forscherin der TU Berlin.→TU-Professorin Dr. Bénédicte Savoy erhält Berliner Wissenschaftspreis

-

Facts & Events

© ASH Berlin

Facts & EventsDas neue Erweiterungsgebäude der ASH Berlin soll Platz für rund 1.700 Studierende und eine neue Mensa schaffen. Im Sommer 2024 soll das Gebäude fertig…→

© ASH Berlin

Facts & EventsDas neue Erweiterungsgebäude der ASH Berlin soll Platz für rund 1.700 Studierende und eine neue Mensa schaffen. Im Sommer 2024 soll das Gebäude fertig…→Alice Salomon Hochschule feiert Richtfest

-

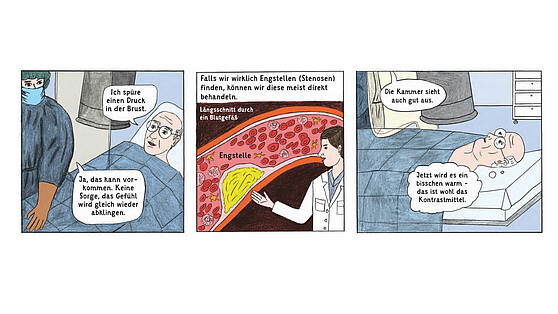

Facts & Events Innovationen

© Brand, Gao, Hamann, Martineck, Stangl/Charité

Facts & Events InnovationenMit einem Comic will die Charité-Universitätsmedizin Berlin Patientinnen und Patienten künftig vor einer Herzkatheter-Untersuchung aufklären. Im…→

© Brand, Gao, Hamann, Martineck, Stangl/Charité

Facts & Events InnovationenMit einem Comic will die Charité-Universitätsmedizin Berlin Patientinnen und Patienten künftig vor einer Herzkatheter-Untersuchung aufklären. Im…→Ein Bild sagt mehr als tausend Worte

-

Facts & Events Transfer – Stories

© BVG/Andreas Süß

Facts & Events Transfer – StoriesWie klingt eigentlich ein E-Bus? Der UdK-Student Lukas Esser hat im Rahmen eines Wettbewerbs den neuen Sound für deutsche E-Busse entwickelt.→

© BVG/Andreas Süß

Facts & Events Transfer – StoriesWie klingt eigentlich ein E-Bus? Der UdK-Student Lukas Esser hat im Rahmen eines Wettbewerbs den neuen Sound für deutsche E-Busse entwickelt.→Elektro-Sound der Zukunft

-

Facts & Events

© DFG/David Ausserhofer

Facts & EventsDie Geisteswissenschaftlerin Prof. Dr. Anita Traninger hat am vergangenen Mittwoch in der Brain City Berlin den Gottfried Wilhelm Leibniz-Preis 2023…→

© DFG/David Ausserhofer

Facts & EventsDie Geisteswissenschaftlerin Prof. Dr. Anita Traninger hat am vergangenen Mittwoch in der Brain City Berlin den Gottfried Wilhelm Leibniz-Preis 2023…→Leibniz-Preis für FU-Professorin Anita Traninger

-

Facts & Events Transfer – Stories

© Maschinenraum

Facts & Events Transfer – StoriesÜber die Zusammenarbeit mit dem bundesweiten Mittelstandsnetzwerk will die Hochschule für Technik und Wirtschaft weiteres Transferpotenzial…→

© Maschinenraum

Facts & Events Transfer – StoriesÜber die Zusammenarbeit mit dem bundesweiten Mittelstandsnetzwerk will die Hochschule für Technik und Wirtschaft weiteres Transferpotenzial…→HTW Berlin kooperiert mit Maschinenraum

-

Facts & Events Transfer – Stories

© Berlin Partner

Facts & Events Transfer – StoriesMit einem neuen Imagefilm startet Brain City Berlin ins Jahr 2023. Protagonistinnen und Protagonisten des Videos sind unsere Brain…→

© Berlin Partner

Facts & Events Transfer – StoriesMit einem neuen Imagefilm startet Brain City Berlin ins Jahr 2023. Protagonistinnen und Protagonisten des Videos sind unsere Brain…→„Wir sind Brain City Berlin“

-

Facts & Events

© DGZfP

Facts & EventsOb Berlin Science Week, Lange Nacht der Wissenschaften, Transfer Week oder World Health Summit – wir stellen Ihnen unsere Favoriten vor.→

© DGZfP

Facts & EventsOb Berlin Science Week, Lange Nacht der Wissenschaften, Transfer Week oder World Health Summit – wir stellen Ihnen unsere Favoriten vor.→Brain City Berlin 2023: Top-10 Events

-

Facts & Events

SOWG © Sarah Rauch/LOC

Facts & Events#ZusammenUnschlagbar: Vom 17. bis zum 25. Juni finden in der Sportmetropole Berlin die Special Olympics World Games 2023 statt. Auch…→

SOWG © Sarah Rauch/LOC

Facts & Events#ZusammenUnschlagbar: Vom 17. bis zum 25. Juni finden in der Sportmetropole Berlin die Special Olympics World Games 2023 statt. Auch…→Als Forscher:in zu den Special Olympics World Games

-

Facts & Events

© Agentur Medienlabor/Benjamin Maltry

Facts & EventsFünf Preise und eine Sonderauszeichnung vergab die Jury des Innovationspreises Berlin Brandenburg am vergangenen Freitag im Rahmen einer…→

© Agentur Medienlabor/Benjamin Maltry

Facts & EventsFünf Preise und eine Sonderauszeichnung vergab die Jury des Innovationspreises Berlin Brandenburg am vergangenen Freitag im Rahmen einer…→Innovationspreis Berlin Brandenburg: die Gewinner:innen 2022

-

Facts & Events Transfer – Stories

© Transfer Week

Facts & Events Transfer – StoriesVom 21. bis zum 25. November können Wissenschaftlerinnen und Wissenschaftler wieder zusammen mit Unternehmen aus Berlin und Brandenburg…→

© Transfer Week

Facts & Events Transfer – StoriesVom 21. bis zum 25. November können Wissenschaftlerinnen und Wissenschaftler wieder zusammen mit Unternehmen aus Berlin und Brandenburg…→Impulse setzen für Kooperationen: Transfer Week 2022

-

Facts & Events

© Dirk Lamprecht / Visual Noise

Facts & EventsMit einem „KULen Tag der Wissenschaft" und einer spannenden Vorlesungsreihe feiert die KinderUni Lichtenberg in diesem Jahr ihr 20-jähriges Jubiläum.→

© Dirk Lamprecht / Visual Noise

Facts & EventsMit einem „KULen Tag der Wissenschaft" und einer spannenden Vorlesungsreihe feiert die KinderUni Lichtenberg in diesem Jahr ihr 20-jähriges Jubiläum.→Von „Süß, lecker – und gefährlich“ bis „freihändig Fahrrad fahren“ – KULe Vorlesungen für Kinder

-

Facts & Events Transfer – Stories

© Falling Walls Foundation

Facts & Events Transfer – StoriesVom 1. bis zum 10. November ist die Brain City Berlin wieder ein Hotspot der internationalen→

© Falling Walls Foundation

Facts & Events Transfer – StoriesVom 1. bis zum 10. November ist die Brain City Berlin wieder ein Hotspot der internationalen→

Science Community. Interview mit Festival-Leiterin…Wissenschaft für den Dialog mit der Gesellschaft öffnen

-

Facts & Events

©Senatsverwaltung für Wissenschaft, Gesundheit, Pflege und Gleichstellung

Facts & EventsNoch bis zum 14. November 2022 können Einzelpersonen und Gruppen Vorschläge für den Berliner Frauenpreis einreichen.→

©Senatsverwaltung für Wissenschaft, Gesundheit, Pflege und Gleichstellung

Facts & EventsNoch bis zum 14. November 2022 können Einzelpersonen und Gruppen Vorschläge für den Berliner Frauenpreis einreichen.→Berliner Frauenpreis 2023

-

Facts & Events

© Urania Berlin

Facts & EventsInnovative, kreative und außergewöhnliche Projekte aus Wissenschaft, Forschung und Design suchen die Urania Berlin und die Berlin Science Week in der…→

© Urania Berlin

Facts & EventsInnovative, kreative und außergewöhnliche Projekte aus Wissenschaft, Forschung und Design suchen die Urania Berlin und die Berlin Science Week in der…→Tabula rasa – bis zum 10. September bewerben!

-

Facts & Events

©Shutterstock/4 PM Production

Facts & EventsÜber akademische und nicht-akademische Karriere-Perspektiven informiert vom 22. bis 25. August 2022 eine Veranstaltung an der TU Berlin.→

©Shutterstock/4 PM Production

Facts & EventsÜber akademische und nicht-akademische Karriere-Perspektiven informiert vom 22. bis 25. August 2022 eine Veranstaltung an der TU Berlin.→Career Week for International Junior Researchers – bis 19. August anmelden!

-

Facts & Events

@ BUA

Facts & EventsJugendliche im Alter von 14 bis 18 Jahren sowie Forschende und Studierende können aktuell Vorschläge für die „Next Grand Challenge“ der Berlin…→

@ BUA

Facts & EventsJugendliche im Alter von 14 bis 18 Jahren sowie Forschende und Studierende können aktuell Vorschläge für die „Next Grand Challenge“ der Berlin…→Berlin University Alliance: Ideen gesucht!

-

Facts & Events

Foto: Futurium © David von Becker

Facts & EventsSommerferien – sechs Wochen, in denen wir die Brain City Berlin einmal ganz neu erkunden können. Und das nicht nur am Wannsee oder Müggelsee. Für…→

Foto: Futurium © David von Becker

Facts & EventsSommerferien – sechs Wochen, in denen wir die Brain City Berlin einmal ganz neu erkunden können. Und das nicht nur am Wannsee oder Müggelsee. Für…→5 Tipps für die Ferien

-

Facts & Events

Foto: htw berlin © Zarko Martovic

Facts & EventsAm 2. Juli 2022 findet die Lange Nacht der Wissenschaften wieder live und vor Ort in der Brain City Berlin statt. Mehr als 60 wissenschaftliche und…→

Foto: htw berlin © Zarko Martovic

Facts & EventsAm 2. Juli 2022 findet die Lange Nacht der Wissenschaften wieder live und vor Ort in der Brain City Berlin statt. Mehr als 60 wissenschaftliche und…→LNDW 2022 – die Welt der Wissenschaft erkunden

-

Facts & Events

Foto: Berlin University Alliance

Facts & Events„Wissen aus Berlin“ heißt ein Youtube-Kanal der Berlin University Alliance. Ende Mai ging die 2. Staffel der Kurzvideos an den Start. Jeweils…→

Foto: Berlin University Alliance

Facts & Events„Wissen aus Berlin“ heißt ein Youtube-Kanal der Berlin University Alliance. Ende Mai ging die 2. Staffel der Kurzvideos an den Start. Jeweils…→Spannende Videos aus der Berliner Forschung

-

Facts & Events

© HTW Berlin/Chris Hartung

Facts & EventsVom 30. Mai bis 3. Juni 2022 können sich Schulabsolventinnen auf der Berliner Woche der Studienorientierung umfassend über die Studienangebote an den…→

© HTW Berlin/Chris Hartung

Facts & EventsVom 30. Mai bis 3. Juni 2022 können sich Schulabsolventinnen auf der Berliner Woche der Studienorientierung umfassend über die Studienangebote an den…→Berliner Woche der Studienorientierung

-

Facts & Events

Foto: Michael Kompe @ HWR Berlin

Facts & EventsDer Verbundantrag von fünf Berliner Hochschulen und ein Antrag der ASH Berlin zur Förderung im Rahmen der bundesweiten Initiative sind bewilligt.→

Foto: Michael Kompe @ HWR Berlin

Facts & EventsDer Verbundantrag von fünf Berliner Hochschulen und ein Antrag der ASH Berlin zur Förderung im Rahmen der bundesweiten Initiative sind bewilligt.→Förderprogramm „Innovative Hochschule“: 2 Berliner Anträge erfolgreich

-

Facts & Events

©Agentur Medienlabor/Adam Sevens

Facts & EventsGesucht werden wieder Produkte, Konzepte und Lösungen, die beispielhaft für die Innnovationsfähigkeit und Wirtschaftskraft der Hauptstadtregion…→

©Agentur Medienlabor/Adam Sevens

Facts & EventsGesucht werden wieder Produkte, Konzepte und Lösungen, die beispielhaft für die Innnovationsfähigkeit und Wirtschaftskraft der Hauptstadtregion…→Innovationspreis Berlin Brandenburg 2022: bis 4. Juli bewerben

-

Facts & Events

Foto: Gary Bendig/Unsplash

Facts & EventsFotos vom Osterhasen gesucht! Ein Citizen Science-Projekt ruft die Berlinerinnen und Berliner dazu auf, Hasen, Kaninchen und Füchse im Stadtgebiet zu…→

Foto: Gary Bendig/Unsplash

Facts & EventsFotos vom Osterhasen gesucht! Ein Citizen Science-Projekt ruft die Berlinerinnen und Berliner dazu auf, Hasen, Kaninchen und Füchse im Stadtgebiet zu…→Stalk den Hasen

-

Facts & Events

Foto: Heiner Witte/Wissenschaft im Dialog

Facts & EventsLeinen los! Vom 3. bis 8. Mai ankert die MS Wissenschaft in der Brain City Berlin. Anschließend startet das schwimmende Science Center wieder auf…→

Foto: Heiner Witte/Wissenschaft im Dialog

Facts & EventsLeinen los! Vom 3. bis 8. Mai ankert die MS Wissenschaft in der Brain City Berlin. Anschließend startet das schwimmende Science Center wieder auf…→Ausstellungs-Tipp: MS Wissenschaft in Berlin

-

Facts & Events

©Syda Productions7stock.adobe.com

Facts & EventsDie Hochschulen der Brain City Berlin kehren zum Präsenzunterricht zurück. Das haben die Berliner Hochschulen und die Senatsverwaltung für…→

©Syda Productions7stock.adobe.com

Facts & EventsDie Hochschulen der Brain City Berlin kehren zum Präsenzunterricht zurück. Das haben die Berliner Hochschulen und die Senatsverwaltung für…→Der Campus wird wieder lebendig

-

Facts & Events

HU Berlin/Matthias Heyde

Facts & EventsForschung über Wimmelbilder entschlüsseln: Die Humboldt-Universität zu Berlin bietet seit März geführte Touren durch den „Bahnhof der Wissenschaften…→

HU Berlin/Matthias Heyde

Facts & EventsForschung über Wimmelbilder entschlüsseln: Die Humboldt-Universität zu Berlin bietet seit März geführte Touren durch den „Bahnhof der Wissenschaften…→Ausstellungs-Tipp: Wissenschafts-Tour im Untergrund

-

Facts & Events

Foto: © Falling Walls Foundation

Facts & EventsOb Berlin Science Week, Lange Nacht der Wissenschaften oder die Rückkehr von Saurier-Star Tristan Otto nach Berlin: Auch in diesem Jahr bietet der…→

Foto: © Falling Walls Foundation

Facts & EventsOb Berlin Science Week, Lange Nacht der Wissenschaften oder die Rückkehr von Saurier-Star Tristan Otto nach Berlin: Auch in diesem Jahr bietet der…→Brain City-Highlights 2022: unsere Top 10

-

Facts & Events

© wörner traxler richter planungsgesellschaft mbH

Facts & EventsDie Charité – Universitätsmedizin Berlin und das Deutsche Herzzentrum Berlin (DHZB) bündeln ihre Kompetenzen. Bis 2028 soll in Nähe des Westhafens für…→

© wörner traxler richter planungsgesellschaft mbH

Facts & EventsDie Charité – Universitätsmedizin Berlin und das Deutsche Herzzentrum Berlin (DHZB) bündeln ihre Kompetenzen. Bis 2028 soll in Nähe des Westhafens für…→Neues Herzzentrum für Berlin

-

Facts & Events

Foto: LAGeSo/Dirk Laessig

Facts & EventsDie Preisträger:innen sind: Caroline Frädrich und Prof. Dr. Josef Köhrle vom Institut für Experimentelle Endokrinologie der Charité –…→

Foto: LAGeSo/Dirk Laessig

Facts & EventsDie Preisträger:innen sind: Caroline Frädrich und Prof. Dr. Josef Köhrle vom Institut für Experimentelle Endokrinologie der Charité –…→„Berliner Forschungspreis für Alternativen zu Tierversuchen“: Projekt von Charité und BfR gewinnt

-

Facts & Events

© WZB/David Ausserhofer

Facts & EventsDer Politikwissenschaftler Michael Zürn hat den Berliner Wissenschaftspreis 2021 erhalten. Der Nachwuchspreis ging an die Theologin Mira Sievers.→

© WZB/David Ausserhofer

Facts & EventsDer Politikwissenschaftler Michael Zürn hat den Berliner Wissenschaftspreis 2021 erhalten. Der Nachwuchspreis ging an die Theologin Mira Sievers.→Berliner Wissenschaftspreis 2021 für Michael Zürn

-

Facts & Events

Foto: Falling Walls Foundation

Facts & EventsVom 1. bis 10. November macht das internationale Festival Wissenschaft erlebbar. Mit 500 Sprecherinnen und Sprechern aus aller Welt und mehr als 200…→

Foto: Falling Walls Foundation

Facts & EventsVom 1. bis 10. November macht das internationale Festival Wissenschaft erlebbar. Mit 500 Sprecherinnen und Sprechern aus aller Welt und mehr als 200…→Berlin Science Week 2021: viele spannende Highlights

-

Facts & Events

Prof. Claudia Langenberg; Prof. Marlis Dürkop-Leptihn; Prof. Gudrun Erzgräber, der Regierende Bürgermeister Michael Müller und Prof. Gesche Joost (v. li. n. re.), Foto: BIH/Konstantin Börner

Facts & EventsEmmanuelle Charpentier, Lise Meitner, Cécile Vogt – viele Berliner Wissenschaftlerinnen haben damals wie heute Bahnberechendes geleistet. Dennoch ist…→

Prof. Claudia Langenberg; Prof. Marlis Dürkop-Leptihn; Prof. Gudrun Erzgräber, der Regierende Bürgermeister Michael Müller und Prof. Gesche Joost (v. li. n. re.), Foto: BIH/Konstantin Börner

Facts & EventsEmmanuelle Charpentier, Lise Meitner, Cécile Vogt – viele Berliner Wissenschaftlerinnen haben damals wie heute Bahnberechendes geleistet. Dennoch ist…→Ausstellung: „Berlin – Hauptstadt der Wissenschaftlerinnen“

-

Facts & Events

Credit: Element5 Digital on Unsplash

Facts & EventsDrei Semestern lang fanden Lehre und Studium auch in der Brain City Berlin überwiegend online statt. Jetzt öffnen Vorlesungssäle, Seminarräume, Labore…→

Credit: Element5 Digital on Unsplash

Facts & EventsDrei Semestern lang fanden Lehre und Studium auch in der Brain City Berlin überwiegend online statt. Jetzt öffnen Vorlesungssäle, Seminarräume, Labore…→Gute Voraussetzungen: Semesterstart 2021/22

-

Facts & Events

Credit: Tag der Deutschen Einheit Halle (Saale)

Facts & EventsAm 3. Oktober ist die Brain City Berlin mit dem „Berlin-Cube“ auf der EinheitsEXPO in Halle (Saale) vor Ort.→

Credit: Tag der Deutschen Einheit Halle (Saale)

Facts & EventsAm 3. Oktober ist die Brain City Berlin mit dem „Berlin-Cube“ auf der EinheitsEXPO in Halle (Saale) vor Ort.→#BRAINCITYBERLIN auf dem Tag der Deutschen Einheit

-

Facts & Events

Facts & EventsDie Berliner Fachhochschulen – vier staatliche und zwei konfessionelle – feiern Geburtstag. Anlässlich des gemeinsamen Jubiläums geben sie mit der…→

Facts & EventsDie Berliner Fachhochschulen – vier staatliche und zwei konfessionelle – feiern Geburtstag. Anlässlich des gemeinsamen Jubiläums geben sie mit der…→50 Jahre – 50 Geschichten

-

Facts & Events

Credit: thisisenginieering/raeng on Unsplah

Facts & EventsBis 20. August anmelden! Mit einer Wikipedia-Schreibwerkstatt wollen das Berlin Institute of Health und die Senatskanzlei die Sichtbarkeit von Berlin…→

Credit: thisisenginieering/raeng on Unsplah

Facts & EventsBis 20. August anmelden! Mit einer Wikipedia-Schreibwerkstatt wollen das Berlin Institute of Health und die Senatskanzlei die Sichtbarkeit von Berlin…→Edit-a-thon: für mehr Wissenschaftlerinnen auf Wikipedia

-

Facts & Events

Facts & EventsMit der Wissenschaftsmesse „Tabula rasa – Wissenschaft zum Anfassen“ bietet die Urania Berlin 40 jungen Wissenschaftlerinnen und Wissenschaftlern ein…→

Facts & EventsMit der Wissenschaftsmesse „Tabula rasa – Wissenschaft zum Anfassen“ bietet die Urania Berlin 40 jungen Wissenschaftlerinnen und Wissenschaftlern ein…→Wettbewerb: innovative und kreative Ideen aus Wissenschaft und Forschung!

-

Facts & Events

Credit: Lars Hübner

Facts & EventsBrain City-Botschafter Prof. Dr. Christian Drosten ist für seine herausragenden Forschungsleistungen mit dem Berliner Wissenschaftspreis 2020…→

Credit: Lars Hübner

Facts & EventsBrain City-Botschafter Prof. Dr. Christian Drosten ist für seine herausragenden Forschungsleistungen mit dem Berliner Wissenschaftspreis 2020…→Berliner Wissenschaftspreis 2020 für Christian Drosten

-

Facts & Events

Credit: Harf Zimmermann/3-D-Visualisierung: Tonio Freitag

Facts & EventsBerlin feiert Wissenschaft. Wir haben einige Highlights für Sie zusammengestellt.→

Credit: Harf Zimmermann/3-D-Visualisierung: Tonio Freitag

Facts & EventsBerlin feiert Wissenschaft. Wir haben einige Highlights für Sie zusammengestellt.→„Wissensstadt Berlin 2021“ – unsere Top 10

-

Facts & Events

Foto: @Harf Zimmermann, 3-D-Visualisierung@ Tonio Freitag

Facts & Events„Berlin will’s wissen“: Mit einer großen Open-Air-Ausstellung vor dem Roten Rathaus geht die „Wissensstadt Berlin 2021“ an den Start.→

Foto: @Harf Zimmermann, 3-D-Visualisierung@ Tonio Freitag

Facts & Events„Berlin will’s wissen“: Mit einer großen Open-Air-Ausstellung vor dem Roten Rathaus geht die „Wissensstadt Berlin 2021“ an den Start.→„Wissensstadt Berlin 2021“ – Festival des Forschens

-

Facts & Events

Facts & EventsIm Rahmen der „Creative Cities Challenge“ sucht das Städte-Netzwerk „Global Innovation Collaborative“ innovative Lösungen, die zur wirtschaftlichen…→

Facts & EventsIm Rahmen der „Creative Cities Challenge“ sucht das Städte-Netzwerk „Global Innovation Collaborative“ innovative Lösungen, die zur wirtschaftlichen…→Verlängert bis 3. August: Wettbewerbs-Aufruf „Creative Cities Challenge 2021”

-

Facts & Events

Facts & EventsUm aktuelle technologische Entwicklungen im Bereich Life Sciences, Austausch und Netzwerken geht es am 12. Mai auf der BIONNALE.→

Facts & EventsUm aktuelle technologische Entwicklungen im Bereich Life Sciences, Austausch und Netzwerken geht es am 12. Mai auf der BIONNALE.→BIONNALE 2021 – jetzt anmelden!

-

Facts & Events

Credit: ThisisEngeneering RAEng on Unsplash

Facts & EventsEs gilt als eines der wichtigsten Instrumente der Berliner Hochschulgleichstellungspolitk: Das „Berliner Programm zur Förderung der Chancengleichheit…→

Credit: ThisisEngeneering RAEng on Unsplash

Facts & EventsEs gilt als eines der wichtigsten Instrumente der Berliner Hochschulgleichstellungspolitk: Das „Berliner Programm zur Förderung der Chancengleichheit…→Berliner Chancengleichheitsprogramm verlängert

-

Facts & Events

Credit: Berlin Partner/Wüstenhagen

Facts & EventsAm 23. und 24. März lädt das CityLAB Berlin Forscher*innen und Smart-City-Expert*innen zu einer Online-Konferenz ein. Die Ergebnisse sollen in die…→

Credit: Berlin Partner/Wüstenhagen

Facts & EventsAm 23. und 24. März lädt das CityLAB Berlin Forscher*innen und Smart-City-Expert*innen zu einer Online-Konferenz ein. Die Ergebnisse sollen in die…→Internationales Symposium zum Thema Smart City

-

Facts & Events

ThisisEngineering RAEng on Unsplash

Facts & EventsBerliner Hochschulen liegen in puncto Gleichstellung über dem bundesweiten Schnitt. 2020 besetzten die staatlichen Hochschulen in der Brain City…→

ThisisEngineering RAEng on Unsplash

Facts & EventsBerliner Hochschulen liegen in puncto Gleichstellung über dem bundesweiten Schnitt. 2020 besetzten die staatlichen Hochschulen in der Brain City…→Hauptstadt der Professorinnen

-

Facts & Events

FU Berlin © Stephan Niespodziany, www.rejoyce.berlin

Facts & EventsDigital, hybrid oder live vor Ort – es wird auf jeden Fall spannend! Wir haben die Highlights für Sie zusammengestellt.→

FU Berlin © Stephan Niespodziany, www.rejoyce.berlin

Facts & EventsDigital, hybrid oder live vor Ort – es wird auf jeden Fall spannend! Wir haben die Highlights für Sie zusammengestellt.→Brain City Berlin 2021: die Top-10 Events

-

Facts & Events

Matthias Heyde, HU Berlin

Facts & EventsWissenschaftlich wimmelt es derzeit im neuen U-Bahnhof Unter den Linden. Eine Ausstellung der Humboldt-Universität zu Berlin zeigt Suchbilder zu…→

Matthias Heyde, HU Berlin

Facts & EventsWissenschaftlich wimmelt es derzeit im neuen U-Bahnhof Unter den Linden. Eine Ausstellung der Humboldt-Universität zu Berlin zeigt Suchbilder zu…→Ausstellungs-Tipp: Wissenschaft im Untergrund

-

Facts & Events

li: TU Berlin, Pressestelle / re. Marten Körner

Facts & EventsGleich mehrere Forscher*innen der Brain City Berlin sind aktuell mit hochkarätigen Förderpreisen ausgezeichnet worden. Den Gottfried Wilhelm…→

li: TU Berlin, Pressestelle / re. Marten Körner

Facts & EventsGleich mehrere Forscher*innen der Brain City Berlin sind aktuell mit hochkarätigen Förderpreisen ausgezeichnet worden. Den Gottfried Wilhelm…→7 hochkarätige Forschungspreise für Berliner Wissenschaftler*innen

-

Facts & Events

Matthias Heyde

Facts & EventsVor rund einem Jahr ging die Berlin University Alliance (BUA) im Rahmen der Exzellenzstrategie von Bund und Ländern an den Start. Dem…→

Matthias Heyde

Facts & EventsVor rund einem Jahr ging die Berlin University Alliance (BUA) im Rahmen der Exzellenzstrategie von Bund und Ländern an den Start. Dem…→1 Jahr Berlin University Alliance

-

Facts & Events

Shutterstock©Gorondenkoff

Facts & EventsBerlin soll zu einem international führenden Zentrum für Künstliche Intelligenz werden. Ein Meilenstein für die Erforschung von KI in der Brain City…→

Shutterstock©Gorondenkoff

Facts & EventsBerlin soll zu einem international führenden Zentrum für Künstliche Intelligenz werden. Ein Meilenstein für die Erforschung von KI in der Brain City…→BIFOLD – dauerhafte Förderung gesichert

-

Facts & Events

Berlin Science Week

Facts & EventsMit mehr als 200 Veranstaltungen und über 500 Vortragenden ist die diesjährige Berlin Science Week größer als jemals zuvor. Allerdings ist das…→

Berlin Science Week

Facts & EventsMit mehr als 200 Veranstaltungen und über 500 Vortragenden ist die diesjährige Berlin Science Week größer als jemals zuvor. Allerdings ist das…→Berlin Science Week 2020 – digital und global

-

Facts & Events

MPG © Hallbauer und Fioretti

Facts & EventsDie Königlich Schwedische Akademie der Wissenschaften hat der Berliner Spitzenforscherin Prof. Dr. Emmanuelle Charpentier und der US-Amerikanerin…→

MPG © Hallbauer und Fioretti

Facts & EventsDie Königlich Schwedische Akademie der Wissenschaften hat der Berliner Spitzenforscherin Prof. Dr. Emmanuelle Charpentier und der US-Amerikanerin…→Nobelpreis Chemie 2020 für Emmanuelle Charpentier – wir gratulieren!

-

Facts & Events

©Mario Gogh/Unsplash

Facts & EventsGründungen aus Berliner Hochschulen heraus haben eine große Bedeutung für die Wirtschaft in der Region. Wie die hochschulübergreifende…→

©Mario Gogh/Unsplash

Facts & EventsGründungen aus Berliner Hochschulen heraus haben eine große Bedeutung für die Wirtschaft in der Region. Wie die hochschulübergreifende…→Hochschul-Start-ups stärken Berliner Wirtschaft

-

Facts & Events

©Samuel Henne

Facts & EventsDie Ausstellung MACHT NATUR im Berliner STATE Studio thematisiert das Unbehagen, das viele von uns angesichts des Eingriffs des Menschen in die Natur…→

©Samuel Henne

Facts & EventsDie Ausstellung MACHT NATUR im Berliner STATE Studio thematisiert das Unbehagen, das viele von uns angesichts des Eingriffs des Menschen in die Natur…→MACHT NATUR – eine Ausstellung, die Fragen stellt

-

Facts & Events

©visitBerlin/Sarah Lindemann

Facts & EventsReallabore bringen Wissenschaftler*innen mit Akteur*innen aus der Praxis zusammen, um im experimentellen Umfeld Lösungen für die Fragen von morgen zu…→

©visitBerlin/Sarah Lindemann

Facts & EventsReallabore bringen Wissenschaftler*innen mit Akteur*innen aus der Praxis zusammen, um im experimentellen Umfeld Lösungen für die Fragen von morgen zu…→Ausstellung „StadtManufaktur Berlin" – Experimentieren für eine lebenswerte Metropole

-

Facts & Events

LNDW/Irmisch

Facts & EventsDie Lange Nacht der Wissenschaften ist jedes Jahr im Juni eines der Highlights im Eventkalender der Brain City Berlin. In diesem Jahr ist alles…→

LNDW/Irmisch

Facts & EventsDie Lange Nacht der Wissenschaften ist jedes Jahr im Juni eines der Highlights im Eventkalender der Brain City Berlin. In diesem Jahr ist alles…→Lange Nacht der Wissenschaften – in diesem Jahr als Podcast-Reihe

-

Facts & Events

©Fotowerk – AdobeStock

Facts & EventsGleich drei neue Gesundheitsstudiengänge starten zum Wintersemester 2020/21 an der Alice Salomon Hochschule Berlin (ASH Berlin).→

©Fotowerk – AdobeStock

Facts & EventsGleich drei neue Gesundheitsstudiengänge starten zum Wintersemester 2020/21 an der Alice Salomon Hochschule Berlin (ASH Berlin).→Jetzt bewerben: 3 neue Gesundheitsstudiengänge an der ASH Berlin

-

Facts & Events

© Futurium/Ali Ghandtschi

Facts & EventsFür all diejenigen, die für die Pfingstfeiertage noch nichts Konkretes geplant haben – hier ein paar Empfehlungen der Brain City-Redaktion, um…→

© Futurium/Ali Ghandtschi

Facts & EventsFür all diejenigen, die für die Pfingstfeiertage noch nichts Konkretes geplant haben – hier ein paar Empfehlungen der Brain City-Redaktion, um…→5 Tipps: zu Pfingsten in der Brain City Berlin

-

Facts & Events

Fotocredit: #MIT Covid-19 Challenge

Facts & EventsExpert*innen unterschiedlichster Fachrichtungen können sich noch bis zum 26. Mai für den zweiten Hackathon „Beat the Pandemic“ bewerben. Ziel des…→

Fotocredit: #MIT Covid-19 Challenge

Facts & EventsExpert*innen unterschiedlichster Fachrichtungen können sich noch bis zum 26. Mai für den zweiten Hackathon „Beat the Pandemic“ bewerben. Ziel des…→Teilnehmer*innen gesucht: MIT-Hackathon „Beat the Pandemic II“

-

Facts & Events

©BIT6

Facts & EventsDie Corona-Krise stellt vor allem kleine und mittelständische Unternehmen vor große Herausforderungen. Am 20. Mai sprechen Expert*innen aus der…→

©BIT6

Facts & EventsDie Corona-Krise stellt vor allem kleine und mittelständische Unternehmen vor große Herausforderungen. Am 20. Mai sprechen Expert*innen aus der…→TRAO – digitaler Transfer-Tag am 20. Mai

-

Facts & Events

©Paul Hahn Photography

Facts & EventsBerlins Wirtschaftssenatorin Ramona Pop und Brandenburgs Wirtschaftsminister Jörg Steinbach haben den Startschuss gegeben für den…→

©Paul Hahn Photography

Facts & EventsBerlins Wirtschaftssenatorin Ramona Pop und Brandenburgs Wirtschaftsminister Jörg Steinbach haben den Startschuss gegeben für den…→Innovationspreis 2020 – bis 22. Juni bewerben!

-

Facts & Events

© Beuth Hochschule / Karsten Flügel

Facts & EventsGebäude, Hörsäle und Labore in der Brain City Berlin sind zurzeit wegen der Corona-Pandemie für Studierende, Lehrende und Forschende geschlossen.…→

© Beuth Hochschule / Karsten Flügel

Facts & EventsGebäude, Hörsäle und Labore in der Brain City Berlin sind zurzeit wegen der Corona-Pandemie für Studierende, Lehrende und Forschende geschlossen.…→COVID-19: Berliner Hochschulen helfen

-

Facts & Events

©FMP/ Barth van Rossum

Facts & EventsMit Viren gegen Influenza, Vogelgrippe – und bald vielleicht auch gegen Corona? Eine Allianz von Wissenschaftler*innen des Leibniz Forschungsinstituts…→

©FMP/ Barth van Rossum

Facts & EventsMit Viren gegen Influenza, Vogelgrippe – und bald vielleicht auch gegen Corona? Eine Allianz von Wissenschaftler*innen des Leibniz Forschungsinstituts…→Berliner Forscher*innen-Allianz entwickelt Influenza-Hemmstoff

-

Facts & Events

©TU Berlin Pressestelle / Dahl

Facts & EventsDie Corona-Pandemie birgt viele Risiken – für Einzelne, aber auch für die Gesellschaft. Doch wie werden die Risiken wahrgenommen? Und wie passen…→

©TU Berlin Pressestelle / Dahl

Facts & EventsDie Corona-Pandemie birgt viele Risiken – für Einzelne, aber auch für die Gesellschaft. Doch wie werden die Risiken wahrgenommen? Und wie passen…→Risikowahrnehmung in der Corona-Krise – Umfrage der TU Berlin

-

Facts & Events

©Marcel/Unsplash

Facts & EventsOb Großes Mausohr, Braunes Langohr, Breitflügelfledermaus oder Großer Abendsegler – Fledermäuse fühlen sich in Berlin besonders wohl. Von 25 in…→

©Marcel/Unsplash

Facts & EventsOb Großes Mausohr, Braunes Langohr, Breitflügelfledermaus oder Großer Abendsegler – Fledermäuse fühlen sich in Berlin besonders wohl. Von 25 in…→Bis zum 8. März bewerben: Fledermaus-Hauptstadt sucht Hobbyforscher

-

Facts & Events

© Falling Walls Foundation

Facts & EventsOb Berlin Science Week, Lange Nacht der Wissenschaften oder Greentech Festival – das Berliner Wissenschaftsjahr 2020 verspricht mindestens so spannend…→

© Falling Walls Foundation

Facts & EventsOb Berlin Science Week, Lange Nacht der Wissenschaften oder Greentech Festival – das Berliner Wissenschaftsjahr 2020 verspricht mindestens so spannend…→Brain City Berlin 2020: 10 Event-Highlights

-

Facts & Events

©TU Berlin Pressestelle

Facts & Events„Berlin Institute for the Foundations of Learning and Data“ (BIFOLD) heißt das neue Konstrukt für KI-Spitzenforschung, welches das Berlin Big Data…→

©TU Berlin Pressestelle

Facts & Events„Berlin Institute for the Foundations of Learning and Data“ (BIFOLD) heißt das neue Konstrukt für KI-Spitzenforschung, welches das Berlin Big Data…→KI-Leuchtturm für Berlin: Millionenförderung durch Bund und Land

-

Facts & Events

shutterstock © andersphoto

Facts & EventsGleich mehrere hochrangige Forschungspreise gehen nach Berlin: Insgesamt fünf herausragende Forscher*innen erhielten Auszeichnungen des Europäischen…→

shutterstock © andersphoto

Facts & EventsGleich mehrere hochrangige Forschungspreise gehen nach Berlin: Insgesamt fünf herausragende Forscher*innen erhielten Auszeichnungen des Europäischen…→Preisgekrönt: 6 Auszeichnungen für Berliner Forscher*innen

-

Facts & Events

©IFAF

Facts & Events22.11.2019 | Interdisziplinarität ist ein Charakteristikum der Berliner Wissenschaft. Das bewies zuletzt die Verleihung des Titels „Exzellenz-…→

©IFAF

Facts & Events22.11.2019 | Interdisziplinarität ist ein Charakteristikum der Berliner Wissenschaft. Das bewies zuletzt die Verleihung des Titels „Exzellenz-…→10 Jahre IFAF – herzlichen Glückwunsch!

-

Facts & Events

©ADN Broadcast

Facts & Events31.10.2019 | Bereits zum zweiten Mal fand am 21. September 2019 ein Falling Walls Lab im nordafrikanischen Tunis statt. Organisiert wurde das Event,…→

©ADN Broadcast

Facts & Events31.10.2019 | Bereits zum zweiten Mal fand am 21. September 2019 ein Falling Walls Lab im nordafrikanischen Tunis statt. Organisiert wurde das Event,…→Brain City Botschafterin organisiert 2. Falling Walls Lab in Tunis

-

Facts & Events

©Berlin Science Week 2019

Facts & Events23.10.2019 | Über 350 Spitzenforscher*innen aus aller Welt, mehr als 130 Veranstaltungen und ein neues Format: der „Berlin Science Campus“. Die Berlin…→

©Berlin Science Week 2019

Facts & Events23.10.2019 | Über 350 Spitzenforscher*innen aus aller Welt, mehr als 130 Veranstaltungen und ein neues Format: der „Berlin Science Campus“. Die Berlin…→10 Tage Wissenschaft pur: Berlin Science Week 2019

-

Facts & Events

©Marvin Meyer/Unsplash

Facts & EventsSo viele Studierende wie noch nie werden voraussichtlich zum Wintersemester 2019/20 an den Hochschulen und Universitäten der Brain City Berlin…→

©Marvin Meyer/Unsplash

Facts & EventsSo viele Studierende wie noch nie werden voraussichtlich zum Wintersemester 2019/20 an den Hochschulen und Universitäten der Brain City Berlin…→Semesterstart: 195.000 Studierende erwartet | 17.10.2019

-

Facts & Events

Fu Berlin / Peter Hirnsel

Facts & EventsBerlin ist eine weltoffene Metropole. Menschen aus über 190 Nationen leben und arbeiten in der Stadt. Und auch immer mehr junge Talente zieht es nach…→

Fu Berlin / Peter Hirnsel

Facts & EventsBerlin ist eine weltoffene Metropole. Menschen aus über 190 Nationen leben und arbeiten in der Stadt. Und auch immer mehr junge Talente zieht es nach…→Berliner Hochschulen besonders international | 10.10.2019

-

Facts & Events

UVB 2019 / André Wagenzik

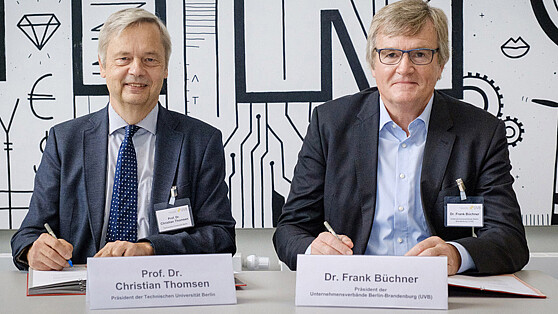

Facts & EventsDie Brain City Berlin gilt bundesweit als einer der wichtigsten Standorte für Künstliche Intelligenz. Um den Technologietransfer zwischen Wissenschaft…→

UVB 2019 / André Wagenzik

Facts & EventsDie Brain City Berlin gilt bundesweit als einer der wichtigsten Standorte für Künstliche Intelligenz. Um den Technologietransfer zwischen Wissenschaft…→Den Digitalen Wandel beschleunigen: TU Berlin und Unternehmensverbände intensivieren Kooperation | 02.10.2019

-

Facts & Events

© ESMT Berlin/Fotografin: Annette Korrol

Facts & EventsSchöner Erfolg auch für die Brain City Berlin: Özlem Bedre-Defolie, Associate Professorin für Wirtschaftswissenschaften an der internationalen…→

© ESMT Berlin/Fotografin: Annette Korrol

Facts & EventsSchöner Erfolg auch für die Brain City Berlin: Özlem Bedre-Defolie, Associate Professorin für Wirtschaftswissenschaften an der internationalen…→Dominanten Plattformen auf der Spur: ESMT-Professorin erhält rund 1,5 Millionen Euro Förderung | 11.09.2019

-

Facts & Events

©Futurium/David von Becker

Facts & EventsDie Zukunft beschäftigt wohl jeden von uns, denn die Zukunft geht uns alle an. Im gestern in der Brain City Berlin eröffneten Futurium kann sich jeder…→

©Futurium/David von Becker

Facts & EventsDie Zukunft beschäftigt wohl jeden von uns, denn die Zukunft geht uns alle an. Im gestern in der Brain City Berlin eröffneten Futurium kann sich jeder…→Öffentlicher Denkraum in der Brain City Berlin: Futurium eröffnet | 06.09.2019

-

Facts & Events

the climate reality project/usplash

Facts & EventsBereits zum dritten Mal findet in der Brain City Berlin die internationale Konferenz „I, Scientist“ statt. Vom 20. bis 21. September 2019 kommen…→

the climate reality project/usplash

Facts & EventsBereits zum dritten Mal findet in der Brain City Berlin die internationale Konferenz „I, Scientist“ statt. Vom 20. bis 21. September 2019 kommen…→Jetzt anmelden! „I, Scientist“ – Genderkonferenz für Wissenschaftler*innen | 25.07.2019

-

Facts & Events

Peitz/Charité

Facts & EventsDie Brain City Berlin bekommt wieder einmal hochkarätigen Zuwachs: Die Medizinerin und Epidemiologin Prof. Dr. Dr. Sabine Gabrysch ist die bundesweit…→

Peitz/Charité

Facts & EventsDie Brain City Berlin bekommt wieder einmal hochkarätigen Zuwachs: Die Medizinerin und Epidemiologin Prof. Dr. Dr. Sabine Gabrysch ist die bundesweit…→Bundesweit erste Professur für Klimawandel und Gesundheit in Berlin | 26.06.2019

-

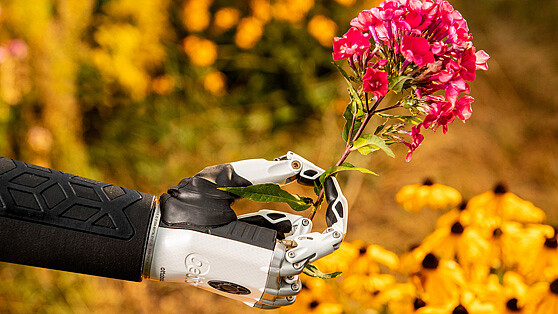

Facts & Events

Ottobock

Facts & EventsLetzter Schultag in Berlin. Endlich Ferien! Doch lernen kann man in der Brain City Berlin auch im Sommer überall. Ein spannendes Ferienprogramm für…→

Ottobock

Facts & EventsLetzter Schultag in Berlin. Endlich Ferien! Doch lernen kann man in der Brain City Berlin auch im Sommer überall. Ein spannendes Ferienprogramm für…→Schlau durch die Sommerferien | 19.06.2019

-

Facts & Events

Florian Reimann

Facts & EventsDie Zukunft der Stadt – wie könnte sie aussehen? Im CityLAB Berlin soll dies durchdacht und erforscht werden. Das Berliner Experimentierlabor wurde…→

Florian Reimann

Facts & EventsDie Zukunft der Stadt – wie könnte sie aussehen? Im CityLAB Berlin soll dies durchdacht und erforscht werden. Das Berliner Experimentierlabor wurde…→Labor für die Digitalisierung Berlins | 13.06.2019

-

Facts & Events

chris knight/unsplash

Facts & EventsBerliner*innen mit ausländischen Wurzeln sind ausgesprochen innovativ. Laut einem Kurzbericht des Instituts der deutschen Wirtschaft (IW) liegt der…→

chris knight/unsplash

Facts & EventsBerliner*innen mit ausländischen Wurzeln sind ausgesprochen innovativ. Laut einem Kurzbericht des Instituts der deutschen Wirtschaft (IW) liegt der…→Berliner*innen mit Migrationshintergrund besonders patent | 29.05.2019

-

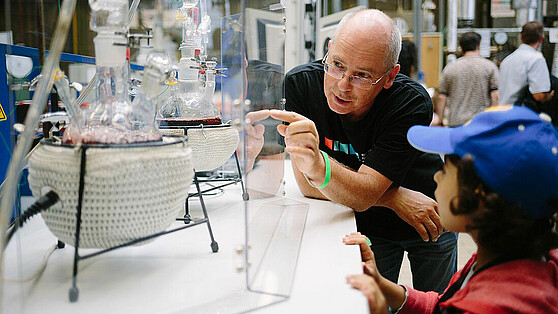

Facts & Events

TU Berlin/Dahl

Facts & EventsBerlin ist einer der spannendsten Wissenschaftsstandorte weltweit. Internationalität, Interdisziplinarität, und eine große Bandbreite an Expertise…→

TU Berlin/Dahl

Facts & EventsBerlin ist einer der spannendsten Wissenschaftsstandorte weltweit. Internationalität, Interdisziplinarität, und eine große Bandbreite an Expertise…→Brain City Berlin – im freien Dialog mit der Welt | 13.05.2019

-

Facts & Events

Berlin Partner / Scholvien

Facts & EventsIn dem weltweit anerkannten QS University Ranking schnitten die Berliner Universitäten in vielen Fachbereichen sehr gut ab. Sie sind 30 Mal unter den…→

Berlin Partner / Scholvien

Facts & EventsIn dem weltweit anerkannten QS University Ranking schnitten die Berliner Universitäten in vielen Fachbereichen sehr gut ab. Sie sind 30 Mal unter den…→QS World University Ranking 2019 - Berliner Unis in vielen Fächern weltweit unter den Besten | 21.03.2019